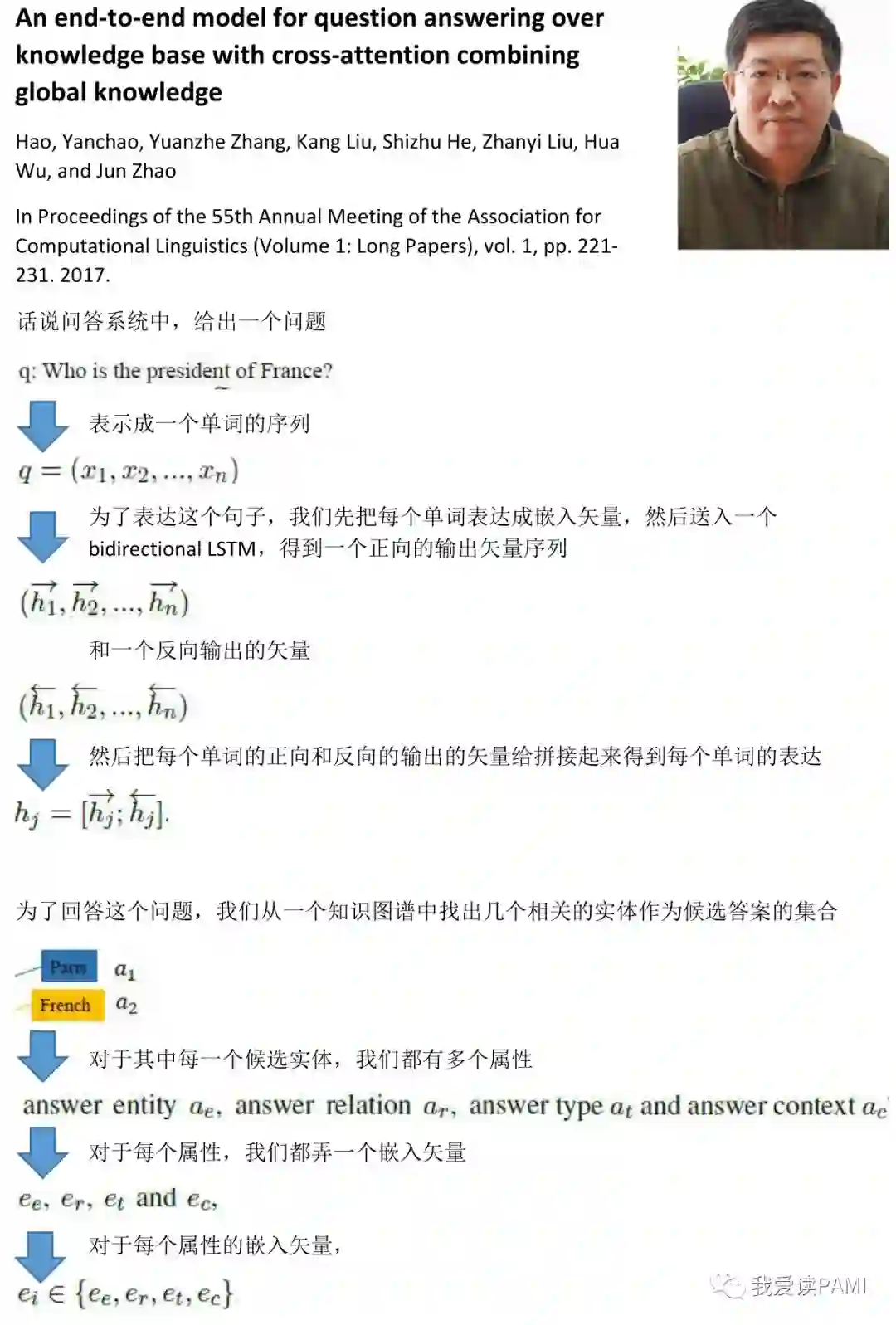

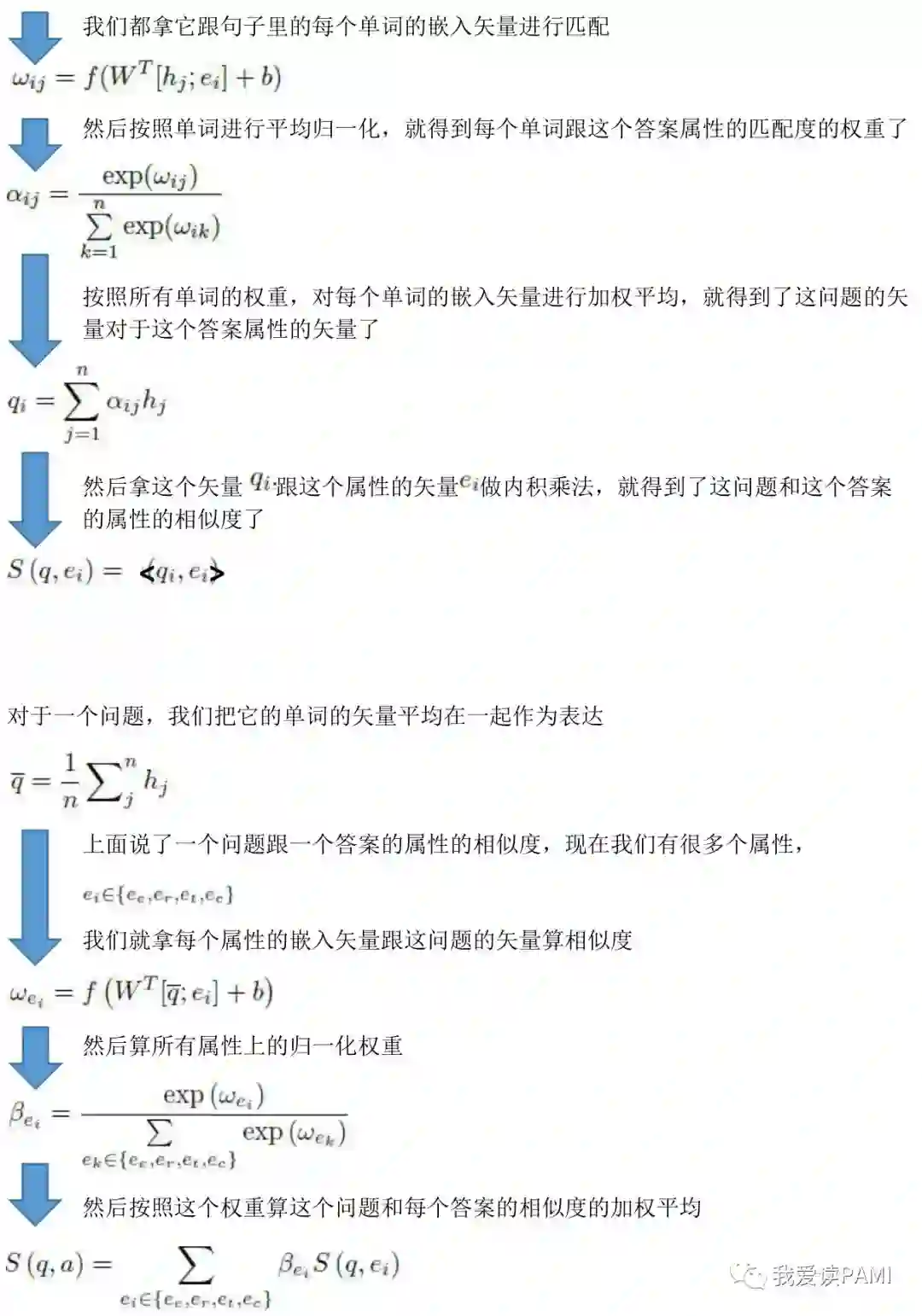

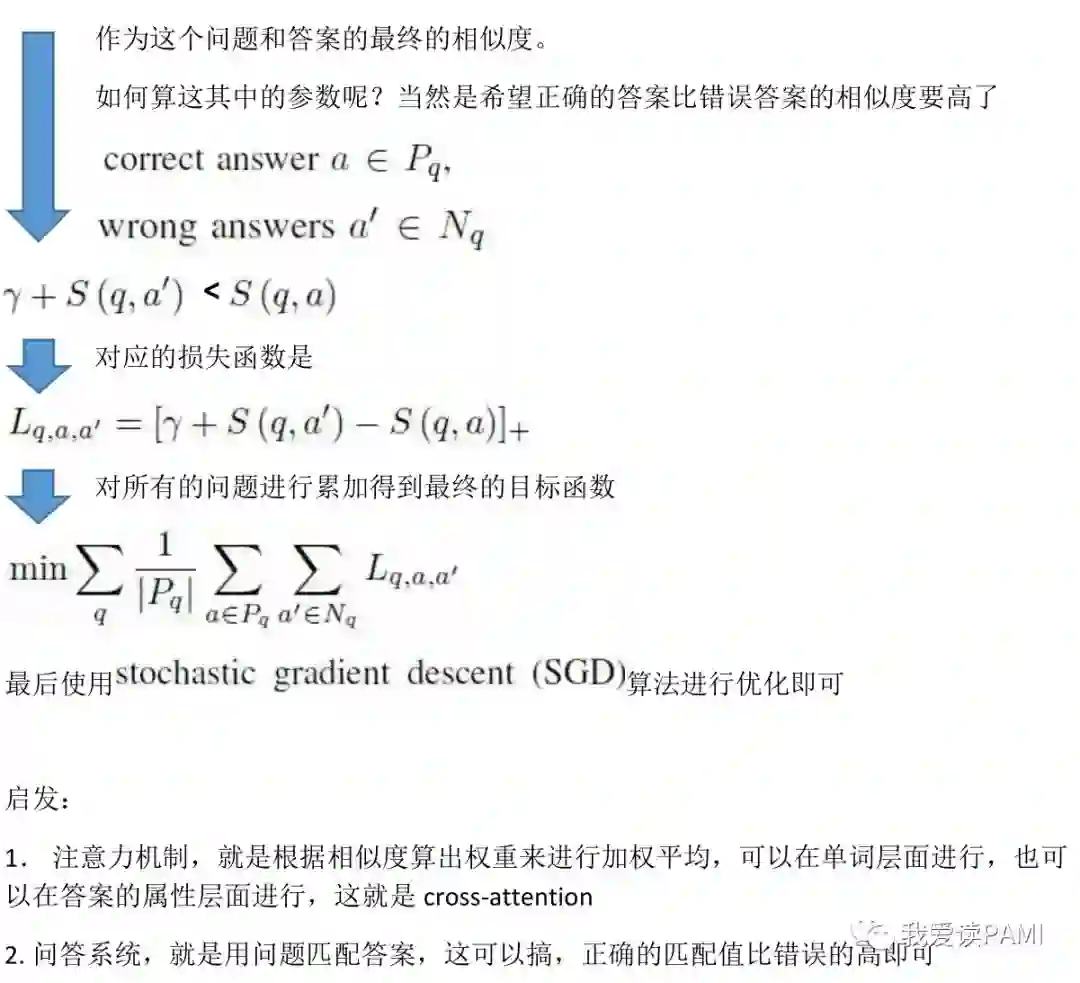

跨越注意力:Cross-Attention

在问答系统中,为了匹配一个问题句子,和一个候选的答案,我们可以注意一个句子中的不同单词,也可以注意这个答案的不同属性。到底该注意哪一个呢?中科院的赵军老师说:可以乱来的,让不同的单词和答案互相交叉着注意。

An end-to-end model for question answering overknowledge base with cross-attention combining global knowledge

Hao, Yanchao, Yuanzhe Zhang, Kang Liu, Shizhu He, ZhanyiLiu, Hua Wu, and Jun Zhao

In Proceedings of the 55th Annual Meeting of theAssociation for Computational Linguistics (Volume 1: Long Papers), vol. 1, pp.221-231. 2017

登录查看更多

相关内容

Attention机制最早是在视觉图像领域提出来的,但是真正火起来应该算是google mind团队的这篇论文《Recurrent Models of Visual Attention》[14],他们在RNN模型上使用了attention机制来进行图像分类。随后,Bahdanau等人在论文《Neural Machine Translation by Jointly Learning to Align and Translate》 [1]中,使用类似attention的机制在机器翻译任务上将翻译和对齐同时进行,他们的工作算是是第一个提出attention机制应用到NLP领域中。接着类似的基于attention机制的RNN模型扩展开始应用到各种NLP任务中。最近,如何在CNN中使用attention机制也成为了大家的研究热点。下图表示了attention研究进展的大概趋势。

Arxiv

4+阅读 · 2018年8月29日