论文题目:Template-Theorems Graph Construction to Enhance Mathematical Reasoning Capabilities of LLM

本文作者:Yarong Lan(浙江大学),Yajing Xu(浙江大学),Huajun Chen(浙江大学)

发表会议:AAAI 2026

论文链接:敬请期待

代码链接:敬请期待

欢迎转载,转载请注明出处****

一、摘要

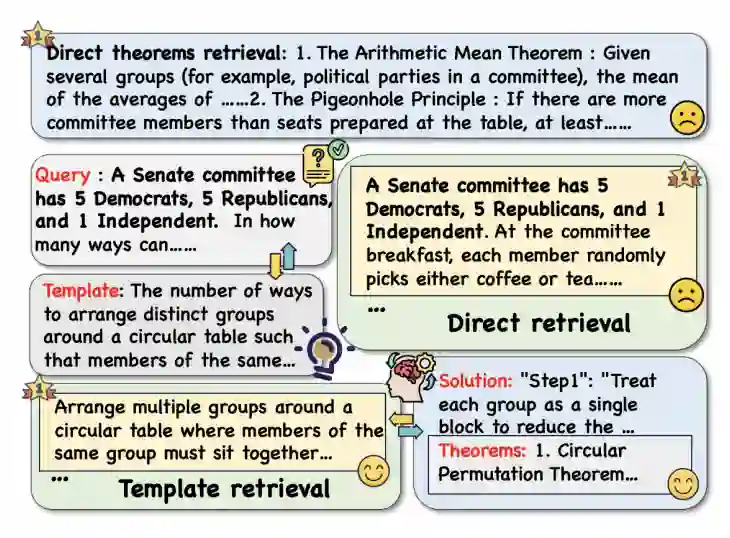

近年来,大语言模型在数学推理任务中取得了显著进展,尤其是在小学和初中级别的数学问题上表现突出。然而,在面对更为复杂、结构隐晦的高中及以上数学问题时,模型的推理能力仍显不足。相较于人类能够快速从记忆中检索相似问题的解决经验并调用相关定理,现有LLM在识别问题结构、关联正确定理方面存在明显短板。

针对这一挑战,本文提出了一种模板-定理图谱构建框架,旨在模仿人类认知中的联想记忆机制,将具体数学问题抽象为通用模板,并建立模板与相关数学定理之间的结构化关联。该框架通过少量种子问题,利用LLM自动扩展构建大规模、高质量的知识图谱,并设计了一套高效的检索与融合机制,在推理时动态提取最相关的模板与定理作为上下文输入,显著提升了模型在复杂数学问题上的表现。 本文在五个公开数学推理数据集上进行了广泛实验,包括MATH、MMLU-Pro-Math、AMC10、AMC12和AIME24,涵盖从初中到大学的多个难度级别。实验表明,所提方法在GPT-4.1、DeepSeek-R1等多个主流模型上均取得了一致的性能提升,同时推理效率也优于传统的少样本链式思维方法。 主要贡献如下: 提出了一种脑启发的模板-定理图谱架构,首次系统地将问题模板与数学定理进行结构化关联,构建了一个可扩展、高可靠的知识库。 设计了一套自动化图谱构建与增强流程,利用LLM从种子问题中生成模板与定理,并通过多阶段验证机制确保数据质量。 在多个数据集和模型上验证了方法的有效性、泛化性与高效性,为数学推理的知识检索与融合提供了新的思路。 二、方法

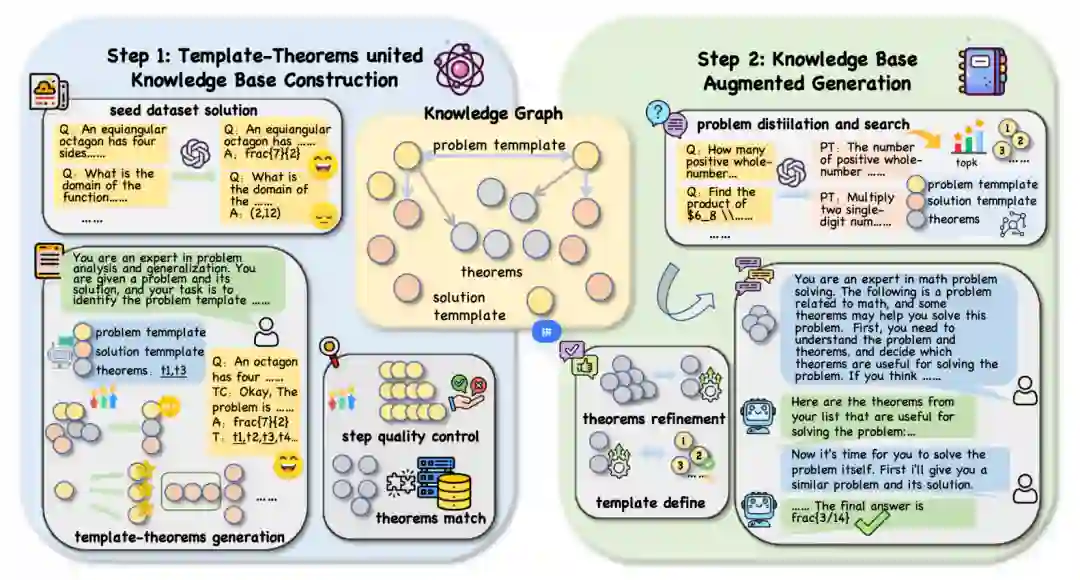

本文提出了一种基于LLM的模板-定理图谱构建与检索增强推理框架,整体流程下图所示。

模板-定理图谱构建 传统检索方法通常基于问题文本的语义相似性,难以捕捉问题间的结构相似性。为此,我们提出将具体问题抽象为问题模板与解题模板,并与相关定理建立关联。 生成阶段 基础生成:从种子数据集中抽取问题与答案,利用LLM生成推理链,并提取过程中调用的定理,形成初步模板与定理对。 进阶生成:通过跨难度采样与模板改写两种方式,扩展模板多样性,避免模型偏见,形成层次化的模板结构。 验证阶段 为确保生成内容的质量,我们设计了多级验证机制: 答案验证:过滤答案错误的样本。 一致性验证:对比基于实际问题和模板问题生成的定理,保留一致性强的内容。 步骤质量控制:根据问题难度过滤步数异常样本。 定理匹配:与权威定理库进行比对,确保逻辑正确性。 图谱检索增强生成 在推理阶段,我们模拟人类的检索过程,从图谱中提取最相关的模板与定理作为上下文输入。 问题提炼:将输入问题抽象为模板形式,提升与图谱的匹配能力。 检索与精炼:基于模板检索Top-K相关条目,整合定理信息,重新选择最优模板,避免信息冲突。 上下文融合:将最终选定的定理表与模板输入下游模型,辅助推理。 三、实验

数据集与模型

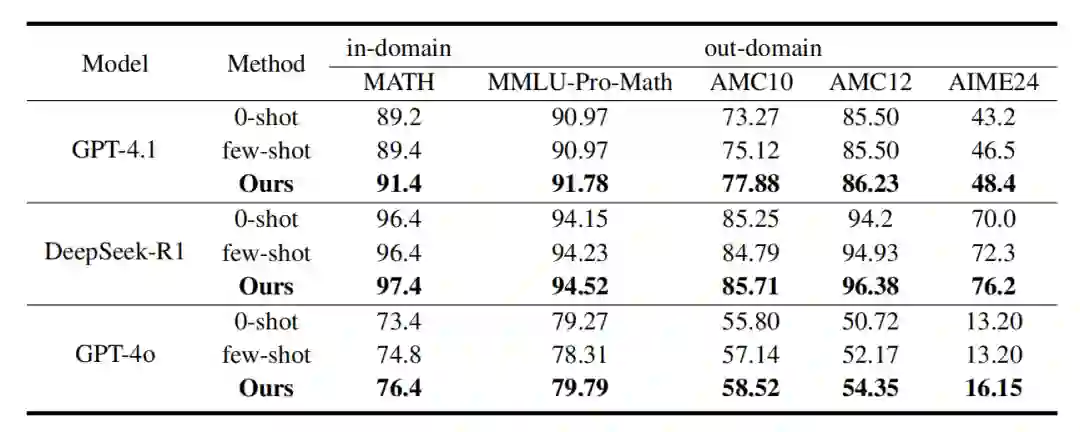

我们在五个数学推理数据集上评估方法: 领域内:MATH 领域外:MMLU-Pro-Math、AMC10、AMC12、AIME24 使用模型包括GPT-4.1、GPT-4o、DeepSeek-R1,对比基线为零样本与少样本链式思维方法。 主要结果

如下表所示,本文方法在多个数据集和模型上均显著优于基线,尤其在领域外数据集上提升明显,说明图谱具备良好的泛化能力。

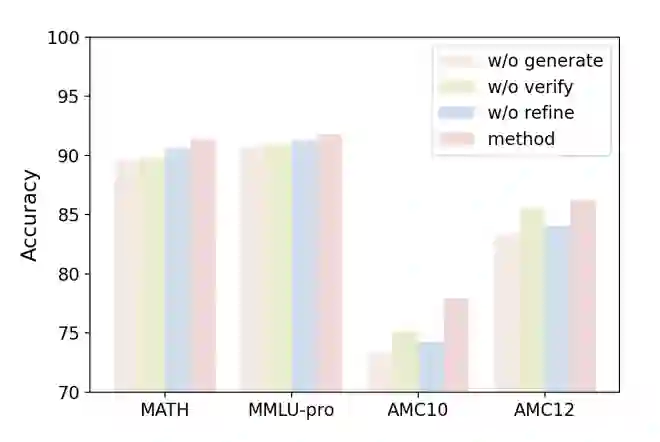

消融实验

我们验证了框架中各个组件的必要性: 缺少高级生成:在领域外数据集上性能下降明显,说明数据多样性至关重要。 缺少质量验证:会导致噪声引入,降低检索知识的有用性。 缺少检索后精炼:直接使用检索到的原始模板和定理可能因不兼容而损害性能。 联合使用模板与定理:实验证明,同时提供模板(经验)和定理(知识)比单独提供任何一种效果更好,印证了人类解题时二者结合的必要性。

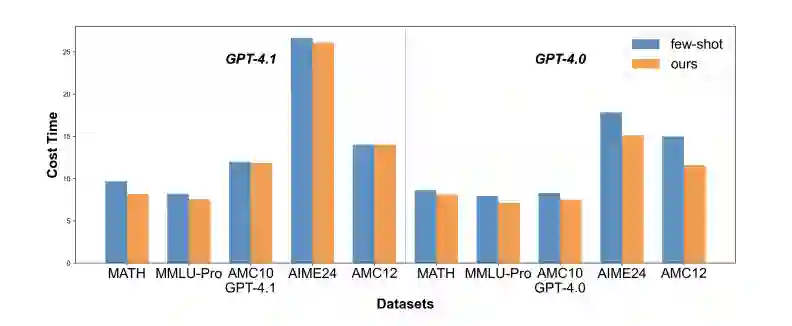

效率分析

如图所示,本文方法在推理时间上普遍低于少样本基线,表明其在提升效果的同时也具备良好的计算效率。

**四、结论 **

本文提出了一种基于模板-定理图谱的数学推理增强框架,通过结构化关联问题模板与数学定理,模仿人类的联想记忆机制,显著提升了大语言模型在复杂数学问题上的表现。实验证明,该方法在多个数据集和模型上均具有优异的泛化能力与效率,为数学推理的知识检索与融合提供了新的解决方案。 未来工作将探索该方法在物理、编程等其它推理密集型学科中的拓展应用。增强生成策略,在面对新问题时,系统性地从图谱中提取最相关的模板和定理信息,作为 LLM 的上下文输入,显著提升其推理准确性和效率。