1 引言

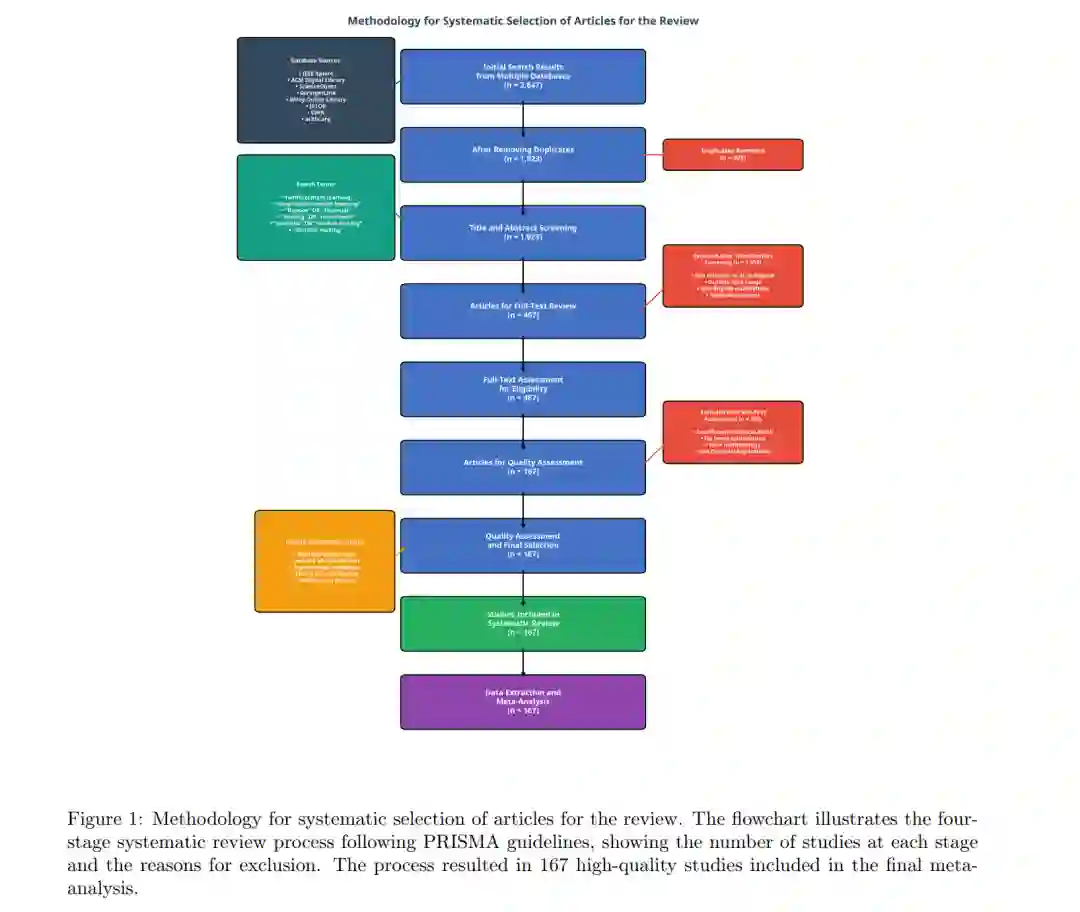

金融市场构成了算法决策领域最具挑战性的环境之一,其特点是高维性、非平稳性以及复杂的依赖关系,传统方法难以有效捕捉这些特征 Cont (2001)。金融理论的演进见证了从经典方法向更复杂方法的重大转变,这些方法承认了传统假设的局限性。正如 Agudelo Aguirre 等人 (2024) 所载,行为金融学从传统金融理论的偏差中脱颖而出,通过在决策中引入行为因素,成为了对古典金融的补充。这一演变反映了学术界更广泛的认知,即金融市场是复杂的自适应系统,传统的计量经济学方法可能显得力不从心。 强化学习(Reinforcement Learning, RL)作为人工智能领域的一种新兴范式,通过直接从市场交互中学习最优策略,为应对这些挑战提供了一种自适应的、数据驱动的方法 Sutton and Barto (2018)。机器学习方法在金融决策中的应用在解决 Bagnara (2022) 所确定的实证资产定价中的“因子动物园(factor zoo)”问题方面尤为突出。实证资产定价的这一最新进展表明,机器学习技术虽然提供了极大的灵活性和预测准确性,但由于它们与传统计量经济学存在巨大差异,因此需要格外谨慎。将 RL 整合到这一更广泛的机器学习框架中,代表了向更具自适应性和响应性的金融决策系统迈出的自然一步。 金融领域应用自适应学习方法的理论基础,通过关于市场效率随时间演变的实证证据得到了进一步加强。Lim 和 Brooks (2011) 对弱式市场有效性文献进行了系统综述,证明了市场效率并非静态属性,而是随时间动态演变的。市场效率的这种时变特性为 RL 等自适应算法创造了机会,使其能够利用暂时的低效性,同时适应不断变化的市场条件。市场效率不断演变的证据,直接支持了采用能够根据观察到的市场行为持续调整策略的学习型方法的合理性。 近年来,在多种因素的共同推动下,RL 在金融决策中的应用势头迅猛。首先,金融数据的前所未有的可用性——包括高频交易数据、替代数据源(alternative data)和实时流数据——为 RL 算法提供了有效学习所需的丰富信息环境 Aldridge (2013); Tsantekidis et al. (2017a)。其次,深度学习架构的进步使 RL 方法能够处理金融应用中典型的高维状态和动作空间 Goodfellow et al. (2016); Heaton et al. (2017)。第三,云计算资源的可访问性和成本效益不断提高,使得复杂的 RL 实现对于更广泛的金融机构而言变得切实可行。 将 RL 应用于金融领域的奠基性工作可以追溯到 Moody 和 Saffell 对交易系统直接强化学习(Direct RL)的开创性研究 Moody and Saffell (2001)。他们的方法证明了 RL 可以在不需要显式预测模型的情况下直接优化交易性能,确立了至今仍影响当代研究的范式。这种直接优化方法与 Bagnara (2022) 确定的金融机器学习的大趋势相一致,即将方法分为正则化、降维、回归树/随机森林、神经网络和对比分析。最近,Jiang 等人引入了专门为投资组合管理问题设计的深度强化学习框架,展示了现代神经网络架构如何有效地与金融应用的 RL 原理相结合 Jiang et al. (2017)。 将 RL 整合到金融机器学习的宏观版图中,代表了与传统计量经济学方法的重大背离。正如 Bagnara (2022) 在全面综述中所指出的,资产定价中的机器学习方法需要特别关注其经济解释性,从而为未来的发展提供启示。这种对经济可解释性的强调对于金融领域的 RL 应用尤为关键,因为所学习的策略不仅必须实现卓越的性能,还必须提供能被金融从业者和监管机构理解和验证的见解。尽管有这些充满前景的发展,但与 RL 取得成功的其他领域相比,金融领域的实际落地面临着许多独特的挑战 Dulac-Arnold et al. (2019); García and Fernández (2015)。这些挑战源于金融环境的内在特征:市场从根本上是非平稳的,其动力学由于监管变化、技术创新和市场参与者行为的演变而不断偏移 Cont (2001); Farmer and Skouras (2013)。Lim 和 Brooks (2011) 关于市场效率随时间演变的证据进一步强调了金融市场的动态性质,以及对能够响应不断变化条件的自适应方法的需求。 在金融环境中,**探索(Exploration)的成本可能高得令人望而却步,因为错误的决策会导致真实的财务损失,而非抽象的性能惩罚。此外,金融应用在严格的监管监督下运行,要求决策过程具有可解释性和可审计性 Doshi-Velez and Kim (2017); Gomber et al. (2017b)。Agudelo Aguirre 等人 (2024) 强调的行为金融学视角又增加了另一层复杂性,因为 RL 系统必须考虑影响市场动态和投资者决策的心理层面、认知偏差及其他行为因素。 监管环境对金融领域采用 RL 既带来了挑战也带来了机遇。AI 治理框架的最新发展强调了对可解释和可审计决策系统的需求,推动了对可解释 RL(Interpretable RL)架构的研究 Puiutta and Veith (2020)。不断演变的监管环境要求 RL 系统在创新与合规之间取得平衡,这需要模型验证和风险管理的新方法 McNeil et al. (2015)。这种监管对可解释性的关注与 Bagnara (2022) 确定的金融机器学习中对经济解释的广泛强调相一致,表明成功的 RL 实现必须同时优先考虑性能和可解释性。 本综述通过对当前文献进行系统分析,识别关于 RL 在金融应用中有效性的模式和见解,从而应对这些挑战。分析揭示了几项重要的发现,这些发现挑战了关于 RL 在金融中有效性的常见假设。将 RL 与传统量化方法相结合的混合方法(Hybrid approaches)**展现出特别的前景,其性能显著优于纯 RL 实现 Fischer and Krauss (2018)。这种向混合方法发展的趋势反映了金融机器学习的更广泛演变,即不同方法的整合通常比单一方法实现产生更好的结果。 做市(Market making)应用持续表现出强劲的性能提升,其次是加密货币交易,而传统的投资组合优化则显示出成熟的迹象 Spooner et al. (2018)。随着 RL 系统被部署到生产环境中,由于模型失效可能产生重大的财务后果,稳健的验证框架变得愈发关键 Bailey et al. (2014)。Lim 和 Brooks (2011) 记录的市场效率时变特性进一步强调了在金融市场部署的 RL 系统中进行持续验证和自适应的重要性。 本综述在四个关键领域做出了贡献: 1. 轻量化智能体 LLM:提出了一套详细的 RL 金融应用分类法,按应用领域、算法策略和性能特征对现有文献进行梳理。该分类建立在广义金融机器学习分类框架的基础上 Bagnara (2022); Shi (2025),并针对 RL 应用进行了扩展。 1. 原生智能体能力诱导:进行了彻底分析,以找出关键影响 RL 结果的因素,并为专业人士提供数据驱动的建议。这些分析结合了市场效率演变 Lim and Brooks (2011) 和行为金融学考量 Agudelo Aguirre and Agudelo Aguirre (2024) 的见解,以全面理解影响金融背景下 RL 性能的因素。 1. 可扩展的智能体轨迹构建:通过严格检查公开可用的研究,解决了金融领域私有性能数据的问题。这种方法应对了金融机器学习研究中的关键挑战之一,即交易策略和性能数据的私有性质往往限制了全面实证证据的可用性。 1. 实证见解:提出了符合监管标准和风险管理协议的实际落地模型,以应对现实世界的部署障碍。这些实现模型融合了金融理论与实践演进的经验教训,包括从古典金融向行为金融方法的转变,以及资产定价中机器学习方法的整合。

分析表明,金融领域成功的 RL 落地与其说是取决于算法的复杂性,不如说是更关键地取决于实施质量、领域专业知识和数据预处理。这一发现与 Bagnara (2022) 确定的金融机器学习的大趋势相一致,即结果的经济解释和实际应用价值往往超过单纯的算法复杂度。研究结果为研究人员和从业者在金融背景下开发有效的 RL 系统提供了基于证据的指导,强调了机器学习研究人员、金融从业者和监管专家之间跨学科协作的重要性。 结合行为金融学 Agudelo Aguirre and Agudelo Aguirre (2024) 和市场效率演变 Lim and Brooks (2011) 的见解,为理解 RL 在金融决策中的作用提供了更全面的基础。这种跨学科方法承认,成功的 RL 实现必须考虑市场动态、参与者行为、监管约束和技术能力之间复杂的相互作用。证据表明,金融 RL 的未来不在于完全取代传统方法,而在于创建复杂的混合系统,利用自适应学习和既有金融理论的双重优势。