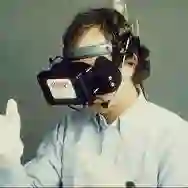

Controlling Unmanned Aerial Vehicles (UAVs) is a cognitively demanding task, with accidents often arising from insufficient situational awareness, inadequate training, and poor user experiences. Providing more intuitive and immersive visual feedback, particularly through Digital Twin technologies, offers new opportunities to enhance pilot awareness and overall experience quality. In this study, we investigate how different virtual points of view (POVs) influence user experience and performance during UAV piloting in Virtual Reality (VR), utilizing a digital twin that faithfully replicates the real-world flight environment. We developed a VR application that enables participants to control a physical DJI Mini 4 Pro drone while immersed in a digital twin with four distinct camera perspectives: Baseline View (static external), First-Person View, Chase View, and Third-Person View. Nineteen participants completed a series of ring-based obstacle courses from each perspective. In addition to objective flight data, we collected standardized subjective assessments of user experience, presence, workload, cybersickness, and situational awareness. Quantitative analyses revealed that the First-Person View was associated with significantly higher mental demand and effort, greater trajectory deviation, but smoother control inputs compared to the Third-Person and Chase perspectives. Complementing these findings, preference data indicated that the Third-Person View was most consistently favored, whereas the First-Person View elicited polarized reactions.

翻译:控制无人机是一项认知负荷较高的任务,事故常因态势感知不足、训练欠缺及用户体验不佳而产生。通过提供更直观、更具沉浸感的视觉反馈,尤其是借助数字孪生技术,为提升飞行员态势感知和整体体验质量提供了新的机遇。本研究探讨了在虚拟现实环境中操控无人机时,不同的虚拟视点如何影响用户体验与操作表现,实验采用了一个能忠实复现真实飞行环境的数字孪生系统。我们开发了一款VR应用程序,使参与者能够在沉浸于数字孪生环境的同时操控一架实体DJI Mini 4 Pro无人机,该环境提供四种不同的摄像机视角:基线视角(静态外部视角)、第一人称视角、跟随视角和第三人称视角。十九名参与者从每种视角出发,完成了一系列基于圆环的障碍航线任务。除客观飞行数据外,我们还收集了关于用户体验、临场感、工作负荷、晕动症及态势感知的标准化主观评估。定量分析表明,与第三人称视角和跟随视角相比,第一人称视角与显著更高的心理需求及努力程度、更大的轨迹偏差相关,但其控制输入更为平滑。偏好数据进一步补充了这些发现:第三人称视角最受一致青睐,而第一人称视角则引发了两极分化的反应。