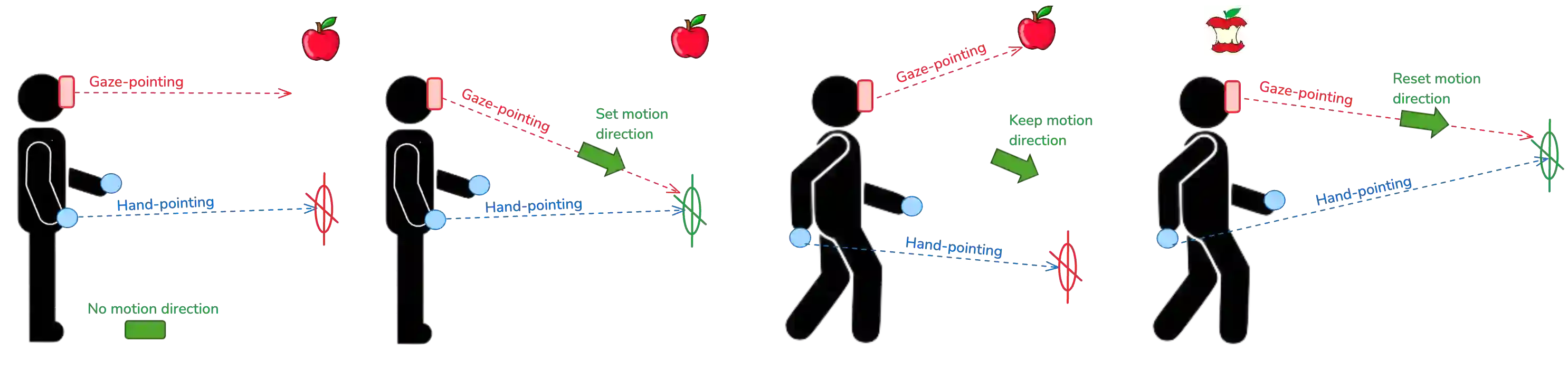

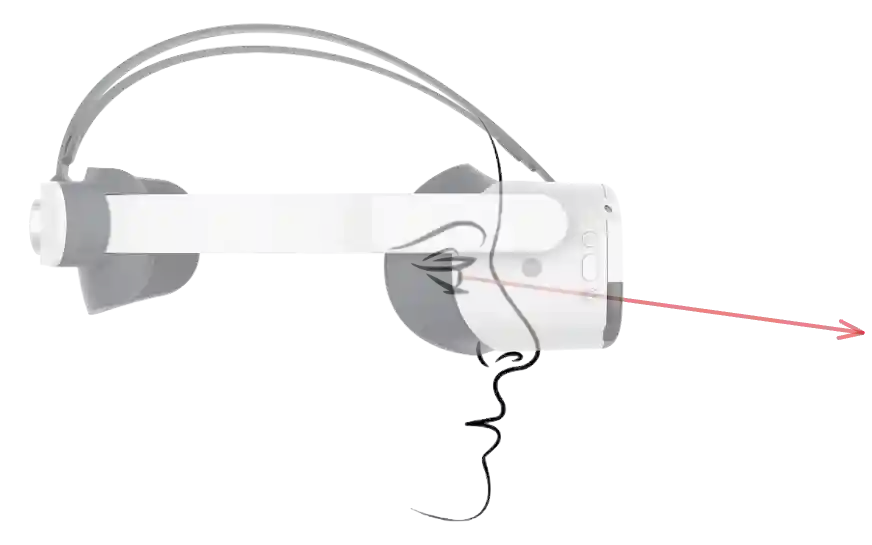

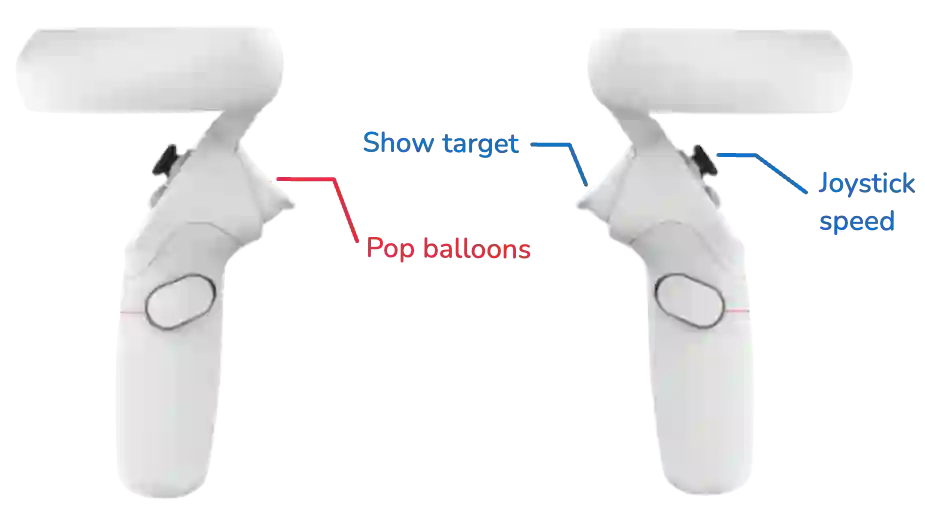

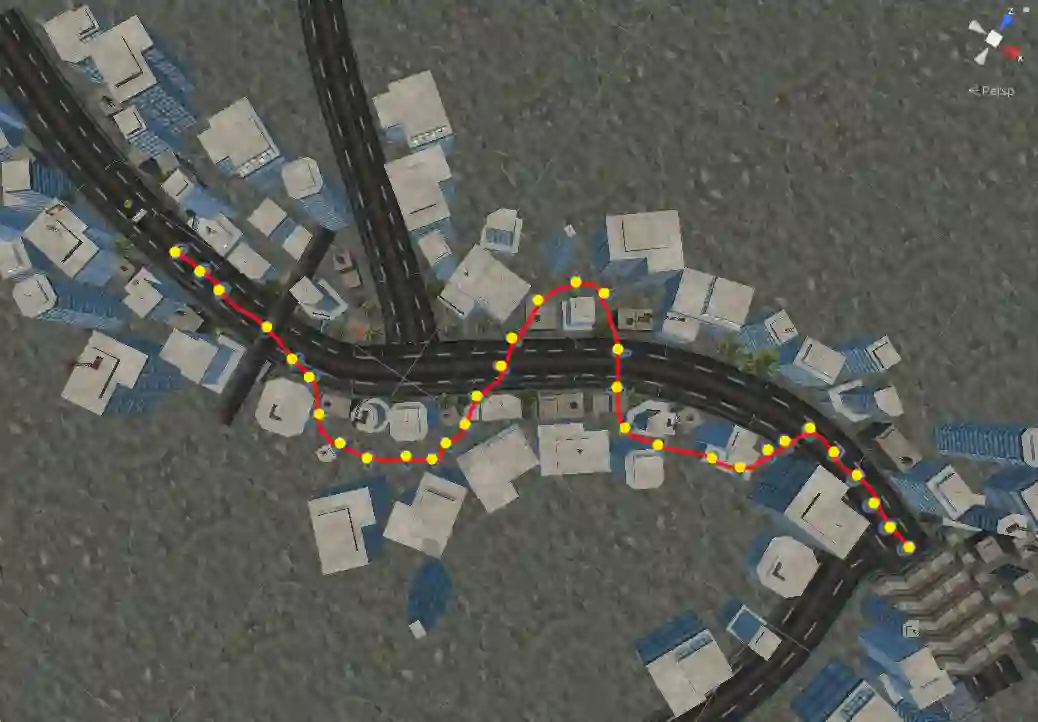

As head-mounted displays (HMDs) with eye-tracking become increasingly accessible, the need for effective gaze-based interfaces in virtual reality (VR) grows. Traditional gaze- or hand-based navigation often limits user precision or impairs free viewing, making multitasking difficult. We present a gaze-hand steering technique that combines eye-tracking with hand-pointing: users steer only when gaze aligns with a hand-defined target, reducing unintended actions and enabling free look. Speed is controlled via either a joystick or a waist-level speed circle. We evaluated our method in a user study (N=20) across multitasking and single-task scenarios, comparing it to a similar technique. Results show that gaze-hand steering maintains performance and enhances user comfort and spatial awareness during multitasking. Our findings support the use of gaze-hand steering in gaze-dominant VR applications requiring precision and simultaneous interaction. Our method significantly improves VR navigation in gaze-dominant, multitasking-intensive applications, supporting immersion and efficient control.

翻译:随着配备眼动追踪功能的头戴式显示器日益普及,虚拟现实中基于视线的有效交互界面需求日益增长。传统的基于视线或手部的导航方式常限制用户操作精度或妨碍自由观察,导致多任务处理困难。本文提出一种视线-手部协同操控技术,将眼动追踪与手部指向相结合:仅当视线与手部定义的目标对齐时用户才执行转向操作,从而减少误操作并实现自由观察。移动速度可通过摇杆或腰部高度速度圆环进行控制。我们通过用户研究(N=20)在多任务与单任务场景中评估本方法,并与同类技术进行对比。结果表明视线-手部协同操控在保持操作性能的同时,显著提升了多任务处理时的用户舒适度与空间感知能力。研究结果支持在需要精确操作与同步交互的视线主导型VR应用中采用视线-手部协同操控技术。本方法能显著改善视线主导型、多任务密集型应用中的VR导航体验,有效支持沉浸感与操控效率。