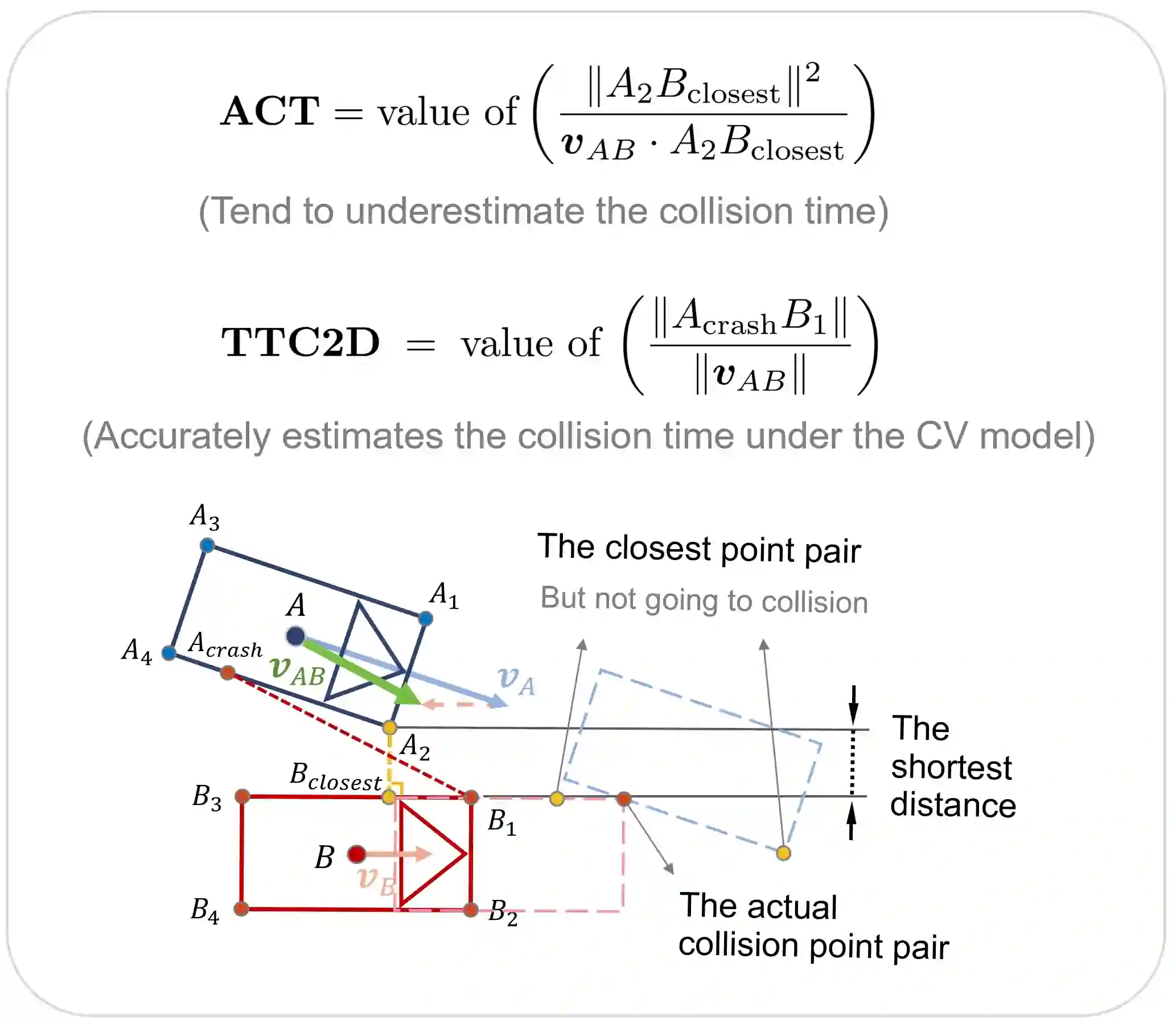

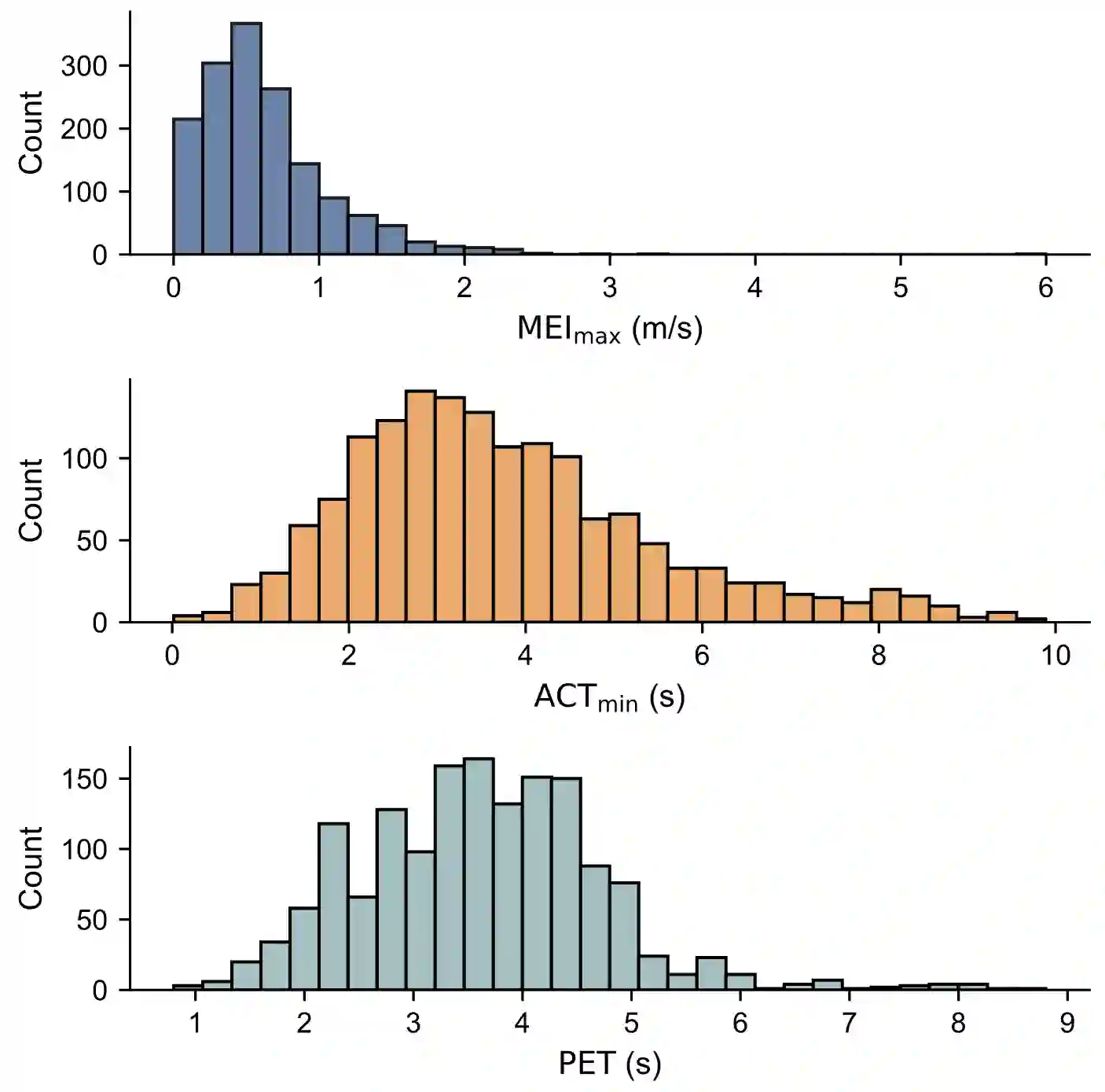

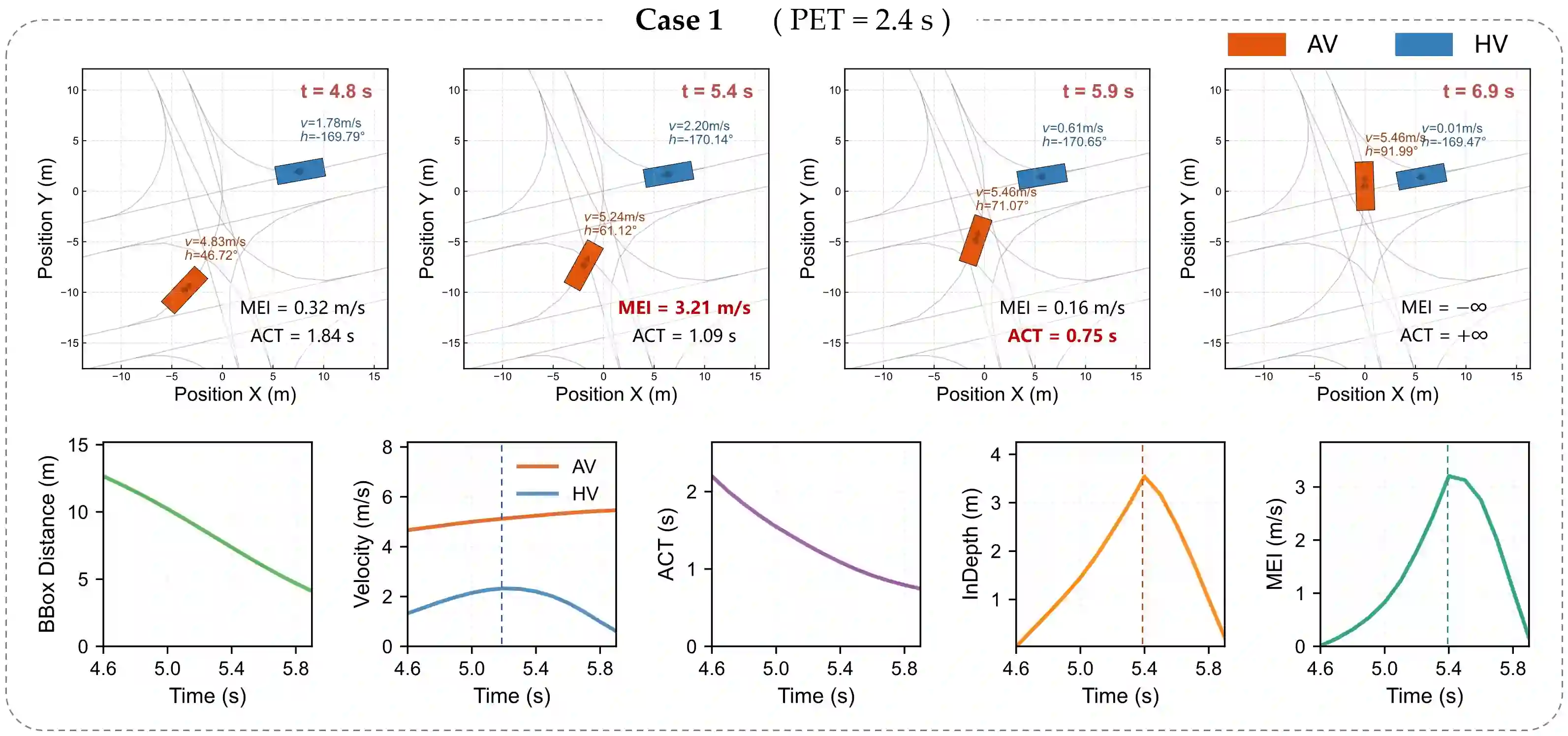

Effective, reliable, and efficient evaluation of autonomous driving safety is essential to demonstrate its trustworthiness. Criticality metrics provide an objective means of assessing safety. However, as existing metrics primarily target longitudinal conflicts, accurately quantifying the risks of lateral conflicts - prevalent in urban settings - remains challenging. This paper proposes the Modified-Emergency Index (MEI), a metric designed to quantify evasive effort in lateral conflicts. Compared to the original Emergency Index (EI), MEI refines the estimation of the time available for evasive maneuvers, enabling more precise risk quantification. We validate MEI on a public lateral conflict dataset based on Argoverse-2, from which we extract over 1,500 high-quality AV conflict cases, including more than 500 critical events. MEI is then compared with the well-established ACT and the widely used PET metrics. Results show that MEI consistently outperforms them in accurately quantifying criticality and capturing risk evolution. Overall, these findings highlight MEI as a promising metric for evaluating urban conflicts and enhancing the safety assessment framework for autonomous driving. The open-source implementation is available at https://github.com/AutoChengh/MEI.

翻译:对自动驾驶安全性进行有效、可靠且高效的评价,对于证明其可信度至关重要。关键性度量指标提供了一种客观的安全评估手段。然而,由于现有指标主要针对纵向冲突,准确量化城市环境中普遍存在的横向冲突风险仍具挑战性。本文提出了修正紧急指数(MEI),这是一种旨在量化横向冲突中规避努力程度的度量指标。相较于原始紧急指数(EI),MEI改进了可用于规避操作的时间估计,从而实现更精确的风险量化。我们在基于Argoverse-2的公开横向冲突数据集上验证了MEI,从中提取了超过1,500个高质量自动驾驶冲突案例,包括500多个关键事件。随后将MEI与成熟的ACT指标及广泛使用的PET指标进行比较。结果表明,MEI在准确量化关键性及捕捉风险演变方面均持续优于这些指标。总体而言,这些发现凸显了MEI作为评估城市冲突、增强自动驾驶安全评估框架的有前景的度量指标。开源实现可在https://github.com/AutoChengh/MEI获取。