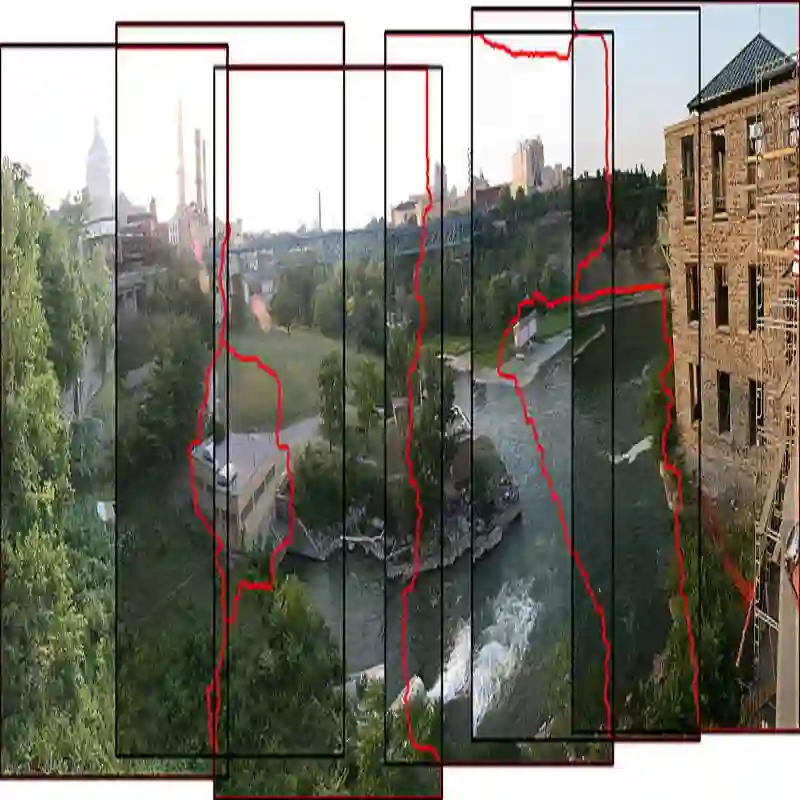

Image stitching synthesizes images captured from multiple perspectives into a single image with a broader field of view. The significant variations in object depth often lead to large parallax, resulting in ghosting and misalignment in the stitched results. To address this, we propose a depth-consistency-constrained seamless-free image stitching method. First, to tackle the multi-view alignment difficulties caused by parallax, a multi-stage mechanism combined with global depth regularization constraints is developed to enhance the alignment accuracy of the same apparent target across different depth ranges. Second, during the multi-view image fusion process, an optimal stitching seam is determined through graph-based low-cost computation, and a soft-seam region is diffused to precisely locate transition areas, thereby effectively mitigating alignment errors induced by parallax and achieving natural and seamless stitching results. Furthermore, considering the computational overhead in the shift regression process, a reparameterization strategy is incorporated to optimize the structural design, significantly improving algorithm efficiency while maintaining optimal performance. Extensive experiments demonstrate the superior performance of the proposed method against the existing methods. Code is available at https://github.com/DLUT-YRH/DSFN.

翻译:图像拼接技术将多视角拍摄的图像合成为一幅具有更广阔视野的单幅图像。物体深度的显著变化常导致较大视差,进而使拼接结果出现重影与错位。为解决此问题,我们提出一种深度一致性约束的无缝合线图像拼接方法。首先,针对视差引起的多视角对齐难题,构建了结合全局深度正则化约束的多阶段机制,以提升不同深度范围内同一表观目标的对齐精度。其次,在多视角图像融合过程中,通过基于图的低成本计算确定最优拼接缝,并扩散软接缝区域以精确定位过渡区,从而有效缓解视差引起的对齐误差,实现自然无缝的拼接效果。此外,考虑到偏移回归过程中的计算开销,引入重参数化策略优化结构设计,在保持最优性能的同时显著提升算法效率。大量实验证明,所提方法相较于现有方法具有更优越的性能。代码公开于 https://github.com/DLUT-YRH/DSFN。