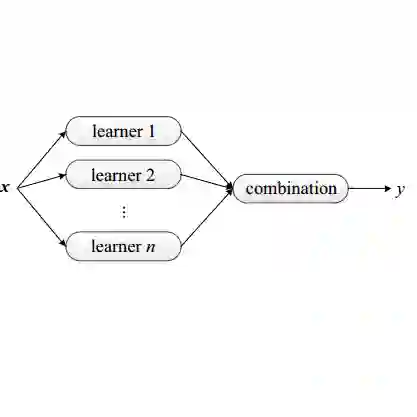

Nature rarely reveals her secrets bluntly, yet in the Fibonacci sequence she grants us a glimpse of her quiet architecture of growth, harmony, and recursive stability \citep{Koshy2001Fibonacci, Livio2002GoldenRatio}. From spiral galaxies to the unfolding of leaves, this humble sequence reflects a universal grammar of balance. In this work, we introduce \emph{Fibonacci Ensembles}, a mathematically principled yet philosophically inspired framework for ensemble learning that complements and extends classical aggregation schemes such as bagging, boosting, and random forests \citep{Breiman1996Bagging, Breiman2001RandomForests, Friedman2001GBM, Zhou2012Ensemble, HastieTibshiraniFriedman2009ESL}. Two intertwined formulations unfold: (1) the use of normalized Fibonacci weights -- tempered through orthogonalization and Rao--Blackwell optimization -- to achieve systematic variance reduction among base learners, and (2) a second-order recursive ensemble dynamic that mirrors the Fibonacci flow itself, enriching representational depth beyond classical boosting. The resulting methodology is at once rigorous and poetic: a reminder that learning systems flourish when guided by the same intrinsic harmonies that shape the natural world. Through controlled one-dimensional regression experiments using both random Fourier feature ensembles \citep{RahimiRecht2007RFF} and polynomial ensembles, we exhibit regimes in which Fibonacci weighting matches or improves upon uniform averaging and interacts in a principled way with orthogonal Rao--Blackwellization. These findings suggest that Fibonacci ensembles form a natural and interpretable design point within the broader theory of ensemble learning.

翻译:自然鲜少直白地揭示其奥秘,然而斐波那契数列让我们得以一窥其生长、和谐与递归稳定性的静谧架构 \citep{Koshy2001Fibonacci, Livio2002GoldenRatio}。从螺旋星系到叶片舒展,这一朴素数列反映了一种普适的平衡法则。本文提出 \emph{斐波那契集成},这是一个数学原理严谨且哲学启发的集成学习框架,对经典的装袋法、提升法和随机森林等聚合方案进行了补充与扩展 \citep{Breiman1996Bagging, Breiman2001RandomForests, Friedman2001GBM, Zhou2012Ensemble, HastieTibshiraniFriedman2009ESL}。其中展开两种交织的构建方式:(1) 采用经正交化与Rao--Blackwell优化调制的归一化斐波那契权重,以实现基学习器间的系统性方差缩减;(2) 一种模拟斐波那契流动本身的二阶递归集成动态,其表征深度超越了经典提升法。所得方法兼具严谨性与诗意:它提示我们,当学习系统遵循塑造自然世界的相同内在和谐律时,便能蓬勃发展。通过使用随机傅里叶特征集成 \citep{RahimiRecht2007RFF} 与多项式集成进行受控一维回归实验,我们展示了斐波那契加权与均匀平均性能相当或更优的机制,并与正交Rao--Blackwell化形成了原理性交互。这些发现表明,斐波那契集成在更广泛的集成学习理论中构成了一个自然且可解释的设计点。