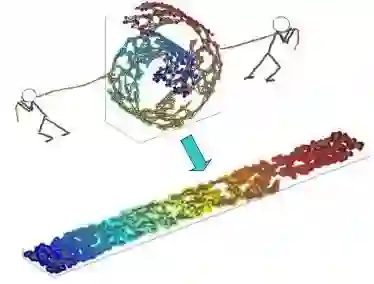

Diffusion-based inverse algorithms have shown remarkable performance across various inverse problems, yet their reliance on numerous denoising steps incurs high computational costs. While recent developments of fast diffusion ODE solvers offer effective acceleration for diffusion sampling without observations, their application in inverse problems remains limited due to the heterogeneous formulations of inverse algorithms and their prevalent use of approximations and heuristics, which often introduce significant errors that undermine the reliability of analytical solvers. In this work, we begin with an analysis of ODE solvers for inverse problems that reveals a linear combination structure of approximations for the inverse trajectory. Building on this insight, we propose a canonical form that unifies a broad class of diffusion-based inverse algorithms and facilitates the design of more generalizable solvers. Inspired by the linear subspace search strategy, we propose Learnable Linear Extrapolation (LLE), a lightweight approach that universally enhances the performance of any diffusion-based inverse algorithm conforming to our canonical form. LLE optimizes the combination coefficients to refine current predictions using previous estimates, alleviating the sensitivity of analytical solvers for inverse algorithms. Extensive experiments demonstrate consistent improvements of the proposed LLE method across multiple algorithms and tasks, indicating its potential for more efficient solutions and boosted performance of diffusion-based inverse algorithms with limited steps. Codes for reproducing our experiments are available at https://github.com/weigerzan/LLE_inverse_problem.

翻译:基于扩散的逆算法在各种逆问题上展现出卓越性能,但其对大量去噪步骤的依赖带来了高昂的计算成本。尽管快速扩散ODE求解器的最新发展为无观测条件下的扩散采样提供了有效加速,但由于逆算法公式的异构性及其广泛使用的近似方法和启发式策略,这些求解器在逆问题中的应用仍然有限——这些近似常引入显著误差,从而削弱解析求解器的可靠性。本文首先分析了用于逆问题的ODE求解器,揭示了逆轨迹近似解的线性组合结构。基于这一发现,我们提出了一种规范形式,该形式统一了广泛的基于扩散的逆算法,并促进了更具泛化能力的求解器设计。受线性子空间搜索策略启发,我们提出了可学习线性外推(LLE)——一种轻量级方法,能普遍提升符合我们规范形式的任何基于扩散的逆算法的性能。LLE通过优化组合系数,利用先前的估计值来优化当前预测,从而减轻解析求解器对逆算法的敏感性。大量实验表明,所提出的LLE方法在多种算法和任务中均能实现持续改进,这预示着其在有限步数下为基于扩散的逆算法提供更高效解决方案和提升性能的潜力。实验复现代码可在 https://github.com/weigerzan/LLE_inverse_problem 获取。