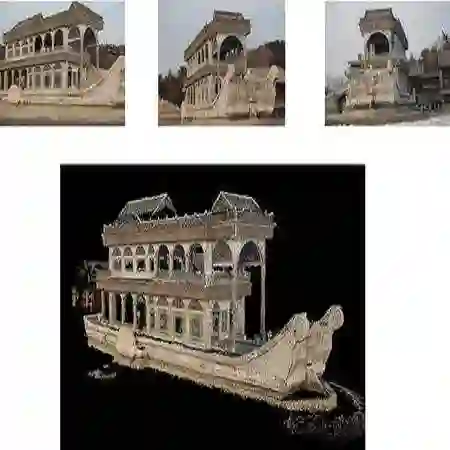

Advances in 3D reconstruction and novel view synthesis have enabled efficient and photorealistic rendering. However, images for reconstruction are still either largely manual or constrained by simple preplanned trajectories. To address this issue, recent works propose generalizable next-best-view planners that do not require online learning. Nevertheless, robustness and performance remain limited across various shapes. Hence, this study introduces Voxel-Face-Aware Hierarchical Next-Best-View Acquisition for Efficient 3D Reconstruction (Hestia), which addresses the shortcomings of the reinforcement learning-based generalizable approaches for five-degree-of-freedom viewpoint prediction. Hestia systematically improves the planners through four components: a more diverse dataset to promote robustness, a hierarchical structure to manage the high-dimensional continuous action search space, a close-greedy strategy to mitigate spurious correlations, and a face-aware design to avoid overlooking geometry. Experimental results show that Hestia achieves non-marginal improvements, with at least a 4% gain in coverage ratio, while reducing Chamfer Distance by 50% and maintaining real-time inference. In addition, Hestia outperforms prior methods by at least 12% in coverage ratio with a 5-image budget and remains robust to object placement variations. Finally, we demonstrate that Hestia, as a next-best-view planner, is feasible for the real-world application. Our project page is https://johnnylu305.github.io/hestia web.

翻译:三维重建与新颖视角合成技术的进展已实现高效且逼真的渲染。然而,用于重建的图像采集仍主要依赖人工操作或受限于简单的预设轨迹。为解决此问题,近期研究提出了无需在线学习的通用化最优视角规划器。然而,其在不同形状物体上的鲁棒性与性能仍存在局限。为此,本研究提出面向高效三维重建的体素-表面感知分层最优视角获取方法(Hestia),该方法针对基于强化学习的五自由度视点预测通用化方法存在的不足,通过四个组件系统性地改进规划器:构建更具多样性的数据集以提升鲁棒性,采用分层结构管理高维连续动作搜索空间,引入近似贪婪策略以缓解伪相关性,以及设计表面感知机制以避免几何特征遗漏。实验结果表明,Hestia 实现了显著改进:覆盖率至少提升 4%,Chamfer 距离降低 50%,同时保持实时推理能力。在 5 张图像的预算约束下,Hestia 的覆盖率较现有方法至少提高 12%,且对物体放置变化保持鲁棒。最后,我们验证了 Hestia 作为最优视角规划器在实际应用中的可行性。项目页面详见 https://johnnylu305.github.io/hestia。