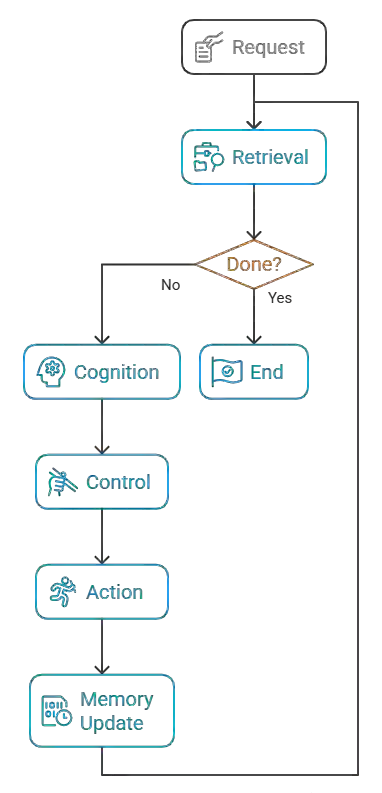

We report a structural convergence among four influential theories of mind: Kahneman's dual-system theory, Friston's predictive processing, Minsky's society of mind, and Clark's extended mind, emerging unintentionally within a practical AI architecture known as Agentic Flow. Designed to address the limitations of large language models (LLMs), Agentic Flow comprises five interlocking modules: Retrieval, Cognition, Control, Memory, and Action, organized into a repeatable cognitive loop. Although originally inspired only by Minsky and Clark, subsequent analysis revealed that its structure echoes computational motifs from all four theories, suggesting that theoretical convergence can emerge naturally from implementation demands rather than deliberate synthesis. Controlled evaluations confirmed this: the structured agent achieved 95.8% task success versus 62.3% for baseline LLMs, demonstrating robust constraint adherence and reproducible reasoning. We describe this convergence under a broader descriptive meta-architecture called PEACE, highlighting recurring design patterns such as predictive modeling, associative recall, and error-sensitive control. Later formalized as the Structured Cognitive Loop (SCL), this framework generalizes the same principles as a foundation for behavioral intelligence in LLM-based agents. Rather than claiming theoretical unification, this paper proposes that intelligent architectures may evolve toward shared structural patterns shaped by practical constraints. As a position paper, it aims to frame this convergence as an interpretive reflection rather than a finalized theory, inviting further theoretical and experimental dialogue. Agentic Flow, or equivalently the Structured Cognitive Loop, thus offers a glimpse of how a unified cognitive form can arise not from abstraction, but from the necessities of real-world reasoning.

翻译:我们报告了四种有影响力的心智理论之间的结构趋同:卡尼曼的双系统理论、弗里斯顿的预测处理理论、明斯基的心智社会理论以及克拉克的延展心智理论,这些理论在一个名为Agentic Flow的实用人工智能架构中无意地涌现出来。Agentic Flow旨在解决大语言模型(LLMs)的局限性,由五个相互锁定的模块组成:检索、认知、控制、记忆和行动,组织成一个可重复的认知循环。尽管最初仅受明斯基和克拉克的启发,但后续分析揭示其结构呼应了所有四种理论中的计算模式,表明理论趋同可以从实现需求中自然涌现,而非刻意综合。受控评估证实了这一点:结构化智能体实现了95.8%的任务成功率,而基线LLMs为62.3%,展现出强大的约束遵循能力和可复现的推理能力。我们在一个更广泛的描述性元架构PEACE下描述了这种趋同,强调了诸如预测建模、联想回忆和误差敏感控制等重复出现的设计模式。随后被形式化为结构化认知循环(SCL),该框架将相同原则泛化为基于LLM的智能体行为智能的基础。本文并非主张理论统一,而是提出智能架构可能朝着由实际约束塑造的共享结构模式演化。作为一篇立场论文,它旨在将这种趋同视为一种解释性反思而非最终理论,以促进进一步的理论与实验对话。因此,Agentic Flow(或等价的结构化认知循环)提供了一个视角,展示统一的认知形式如何并非源于抽象,而是源于现实世界推理的必要性。