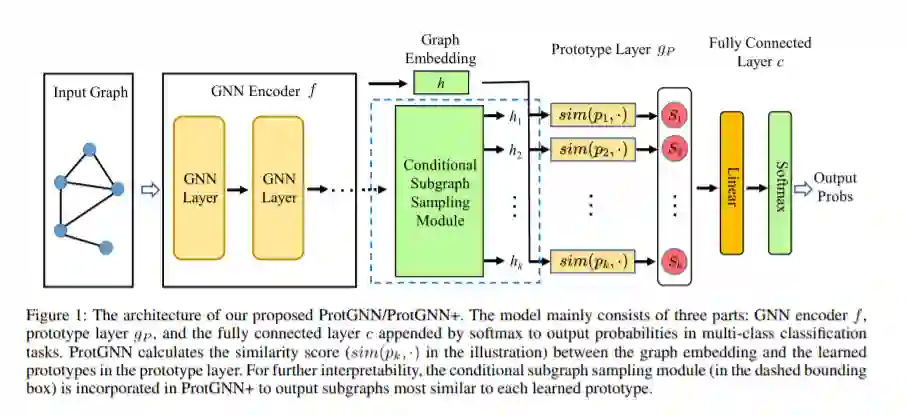

尽管图神经网络(GNNs)的研究近来取得较大进展,但如何解释GNN的预测仍是一个具有挑战性的难题。现有的解释方法主要集中在事后解释上,无法揭示GNN的原始推理过程,因此,建立具有内在可解释性的GNN是非常有必要的。本文中,作者提出了原型图神经网络模型(ProtGNN),它将原型学习与GNN相结合,为GNN的解释提供了一个新的视角。在ProtGNN中,解释是由基于案例的推理过程自然产生的,并在分类过程中实际使用。ProtGNN的分类预测是通过将输入与潜在空间中学习到的一些原型进行相似度比较而得到的;此外,为了获得更好的可解释性和更高的效率,在ProtGNN+中加入了一个新的条件子图采样模块,以表明输入图的哪一部分与每个原型最相似。最后,作者在广泛的数据集上评估上述模型,并进行了具体的案例研究,结果表明,ProtGNN / ProtGNN+可以提供较好的内在解释性,同时达到与现有的不可解释的GNN相当的分类精度。

文章地址 https://www.zhuanzhi.ai/paper/c98ef05dcad9c6869ae93e74de5ffec2

成为VIP会员查看完整内容

相关内容

Arxiv

1+阅读 · 2022年4月19日

Arxiv

14+阅读 · 2021年2月16日