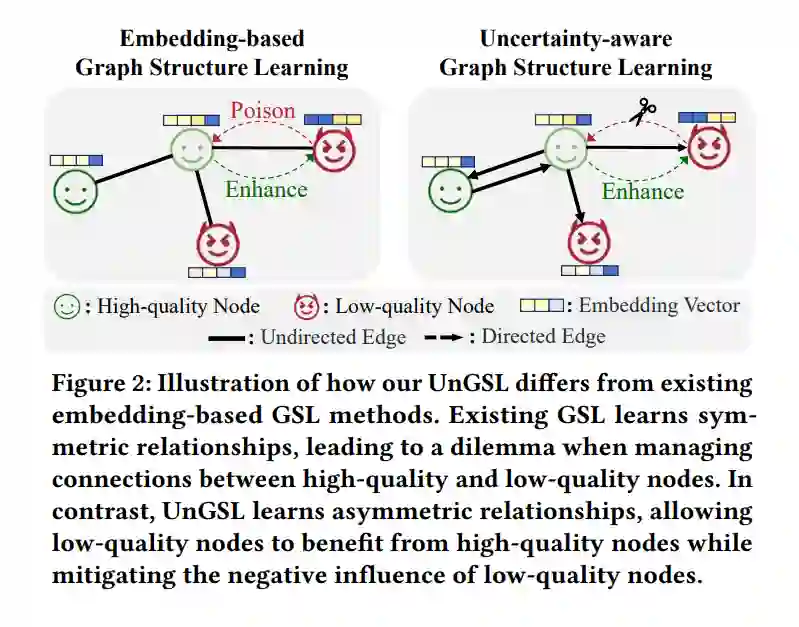

图神经网络(GNNs)已经成为从图结构数据中学习的主要方法。然而,当图结构不理想时,它们的有效性可能会受到显著影响。为了解决这一问题,图结构学习(GSL)作为一种有前景的技术应运而生,它能够自适应地优化节点之间的连接。然而,我们发现现有GSL方法存在两个关键限制:1)大多数方法主要关注节点相似性来构建关系,而忽视了节点信息的质量。盲目连接低质量节点并聚合其模糊信息可能会降低其他节点的性能。2)构建的图结构通常被限制为对称结构,这可能会限制模型的灵活性和有效性。 为克服这些限制,我们提出了一种基于不确定性的图结构学习(UnGSL)策略。UnGSL估计节点信息的不确定性,并利用它来调整方向性连接的强度,其中高不确定性的节点的影响会自适应地减弱。重要的是,UnGSL作为一个插件模块,可以无缝地集成到现有的GSL方法中,且仅需最小的额外计算成本。在我们的实验中,我们将UnGSL实现到六种具有代表性的GSL方法中,展示了持续的性能提升。代码可在此链接获取:https://github.com/UnHans/UnGSL。

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日

Arxiv

231+阅读 · 2023年4月7日