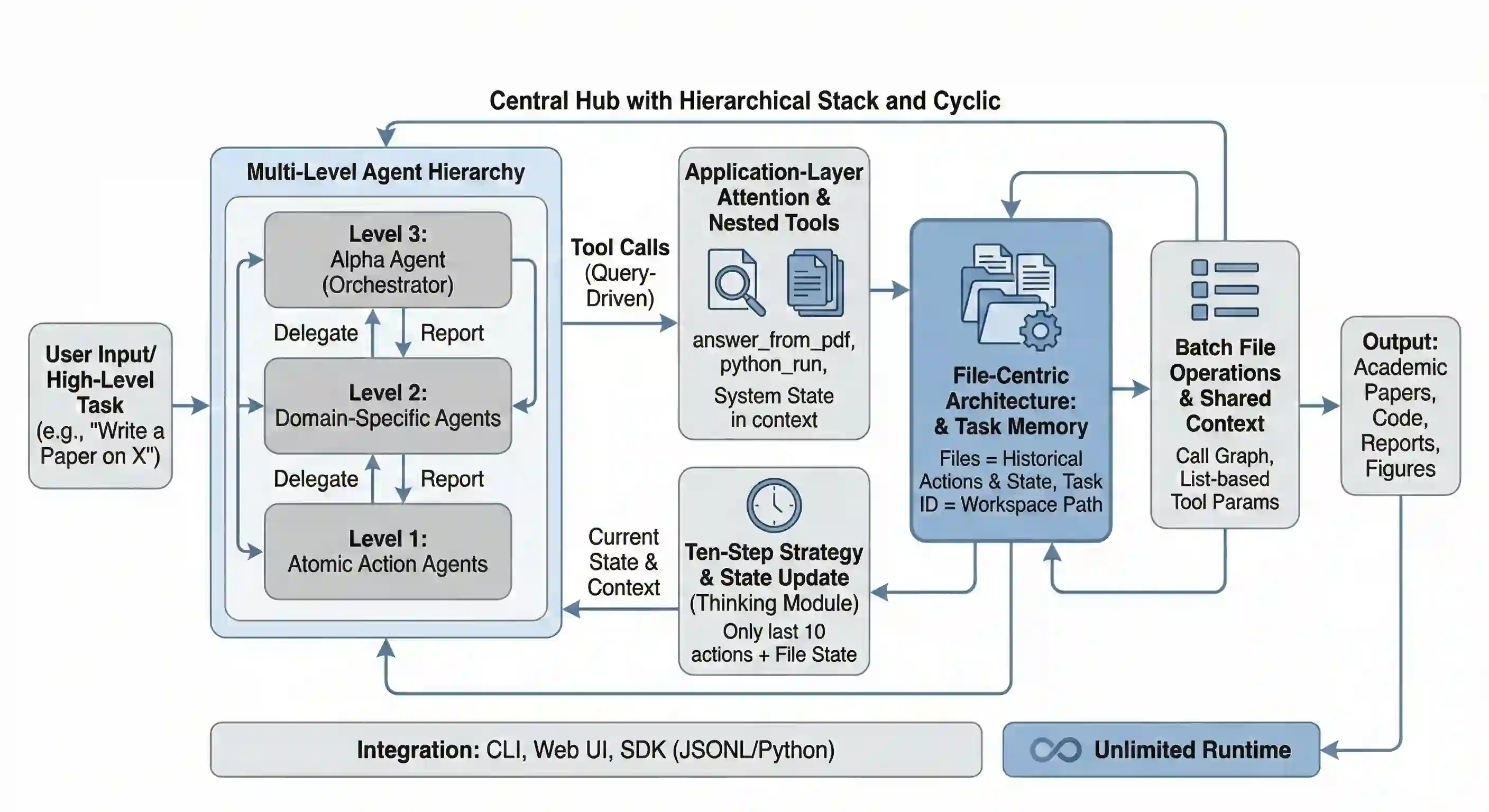

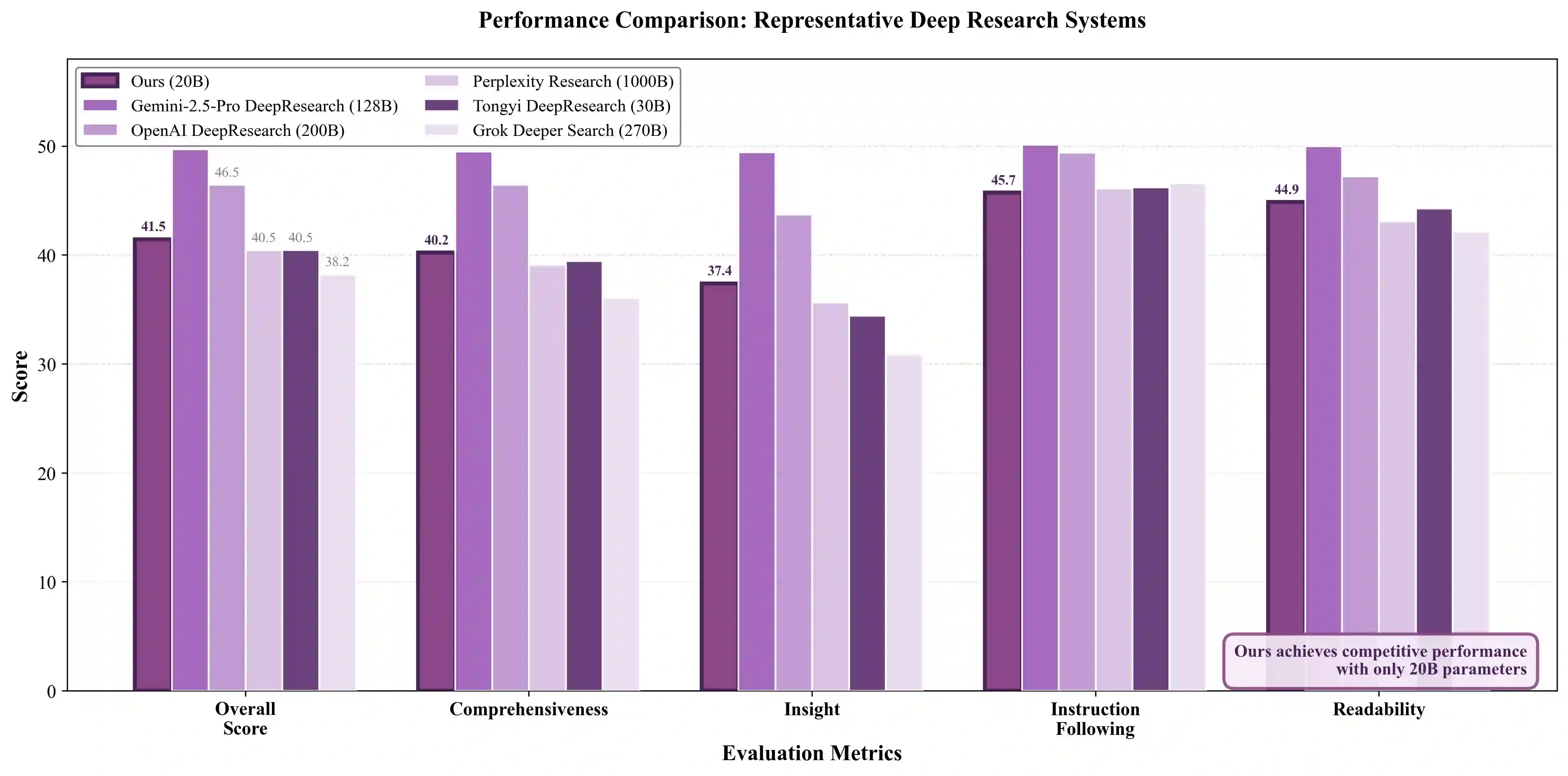

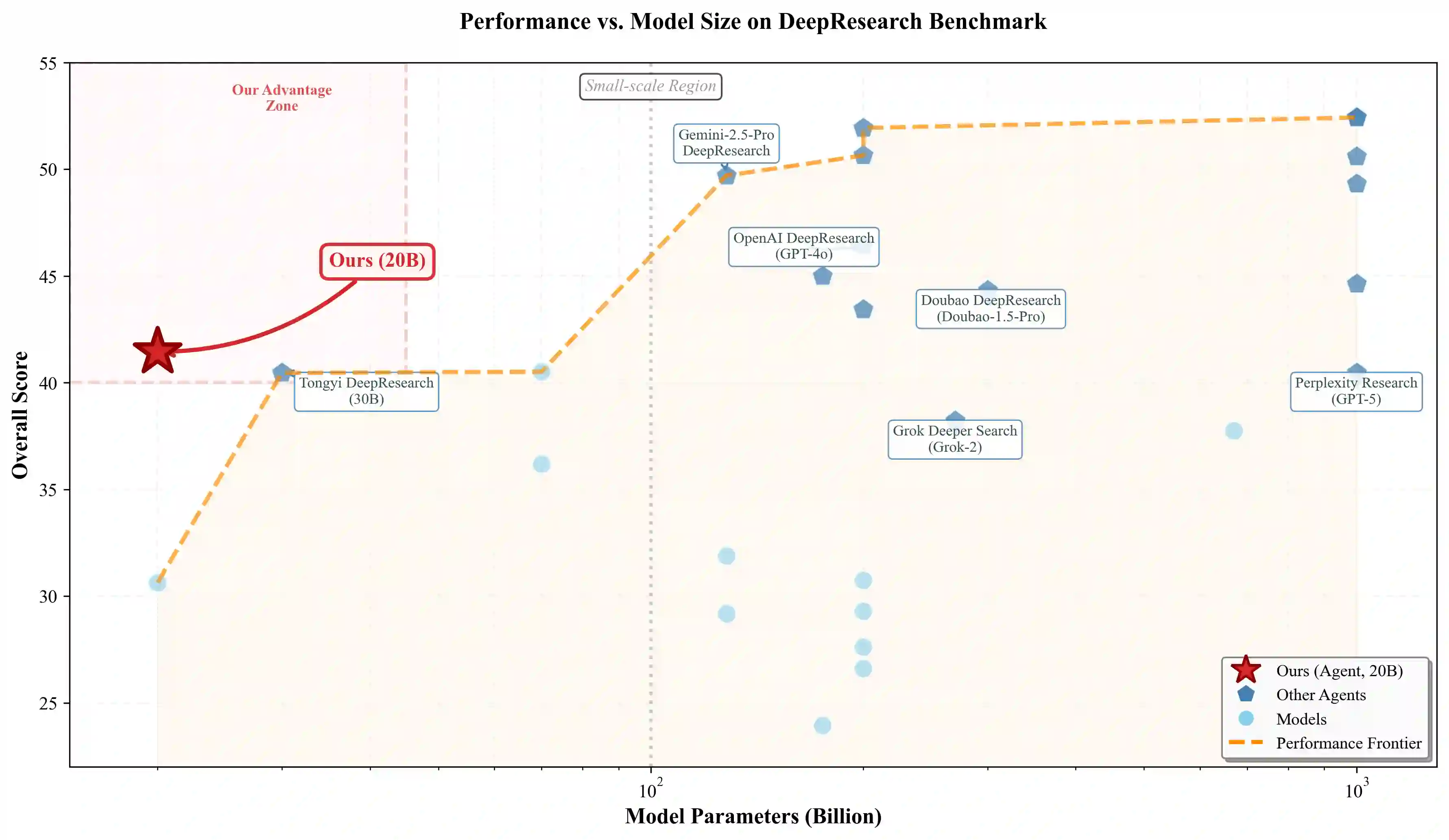

LLM agents can reason and use tools, but they often break down on long-horizon tasks due to unbounded context growth and accumulated errors. Common remedies such as context compression or retrieval-augmented prompting introduce trade-offs between information fidelity and reasoning stability. We present InfiAgent, a general-purpose framework that keeps the agent's reasoning context strictly bounded regardless of task duration by externalizing persistent state into a file-centric state abstraction. At each step, the agent reconstructs context from a workspace state snapshot plus a fixed window of recent actions. Experiments on DeepResearch and an 80-paper literature review task show that, without task-specific fine-tuning, InfiAgent with a 20B open-source model is competitive with larger proprietary systems and maintains substantially higher long-horizon coverage than context-centric baselines. These results support explicit state externalization as a practical foundation for stable long-horizon agents. Github Repo:https://github.com/ChenglinPoly/infiAgent

翻译:大型语言模型智能体能够进行推理并使用工具,但在处理长视野任务时,常因上下文无限增长和误差累积而失效。常见的解决方案(如上下文压缩或检索增强提示)需要在信息保真度与推理稳定性之间进行权衡。本文提出InfiAgent,一种通用框架,通过将持久状态外部化为以文件为中心的状态抽象,使智能体的推理上下文严格受限,不受任务时长影响。在每一步中,智能体从工作空间状态快照加上固定窗口的近期动作重建上下文。在DeepResearch和一项包含80篇文献的综述任务上的实验表明,未经任务特定微调的InfiAgent,使用200亿参数的开源模型即可与更大的专有系统竞争,并在长视野覆盖率上显著优于以上下文为中心的基线方法。这些结果支持显式状态外部化作为稳定长视野智能体的实用基础。项目代码库:https://github.com/ChenglinPoly/infiAgent