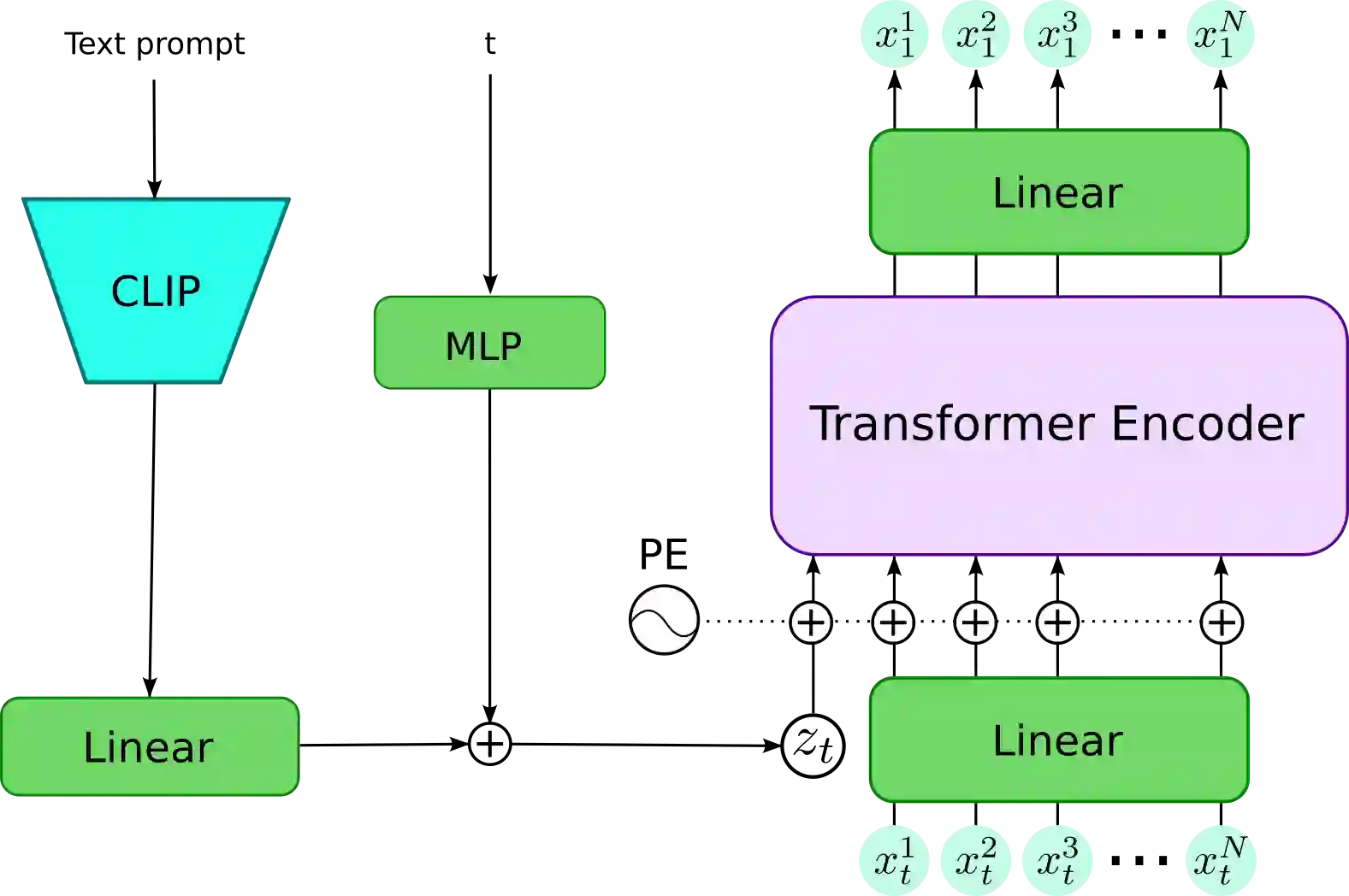

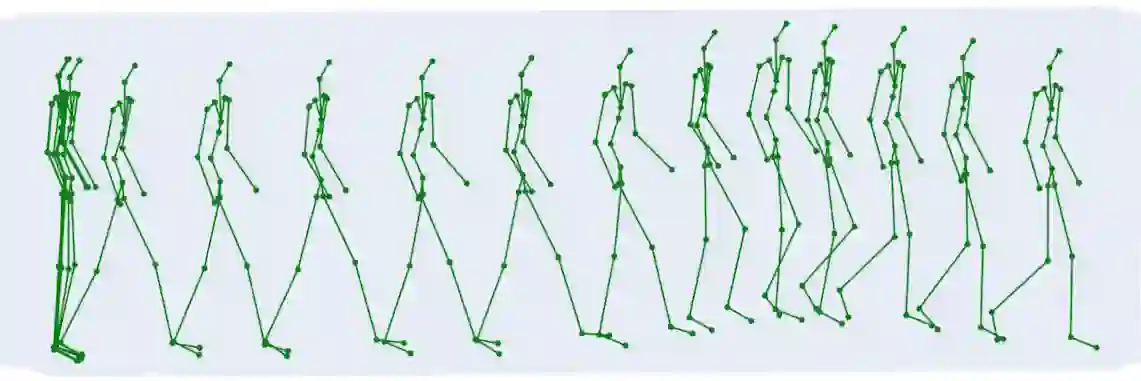

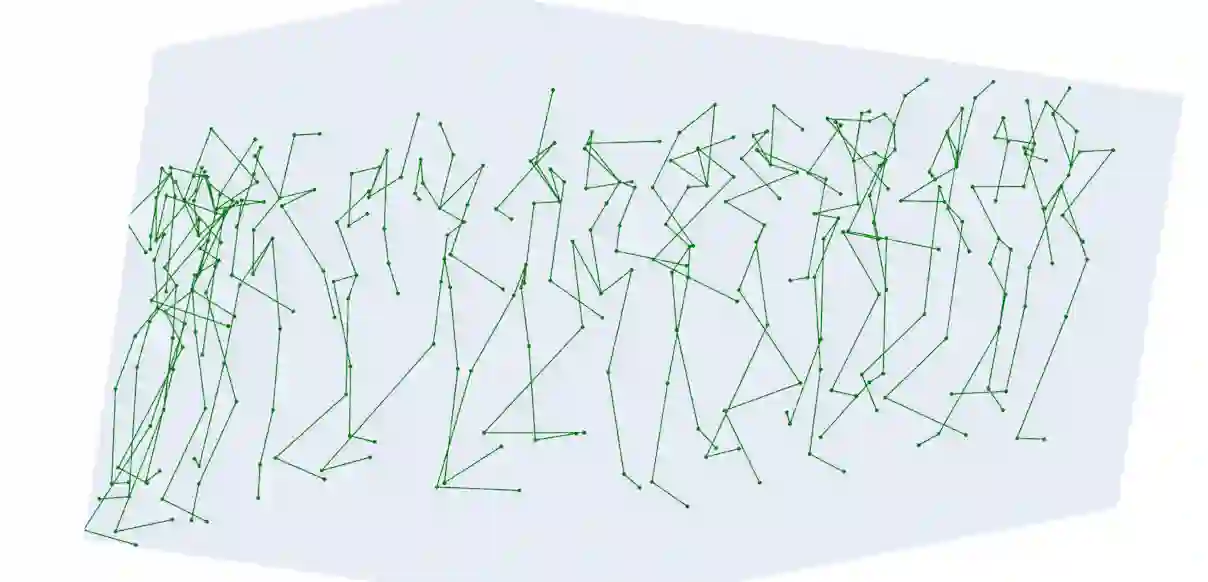

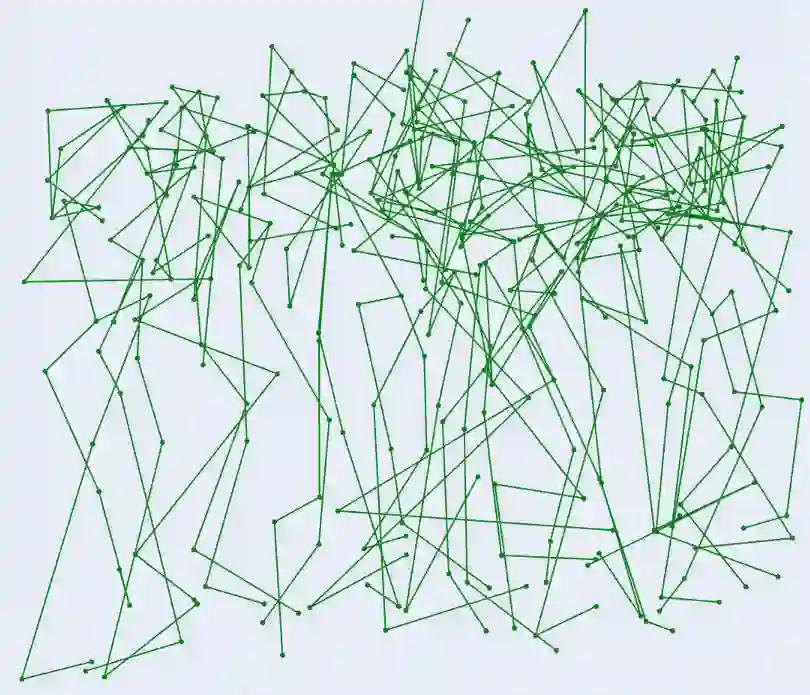

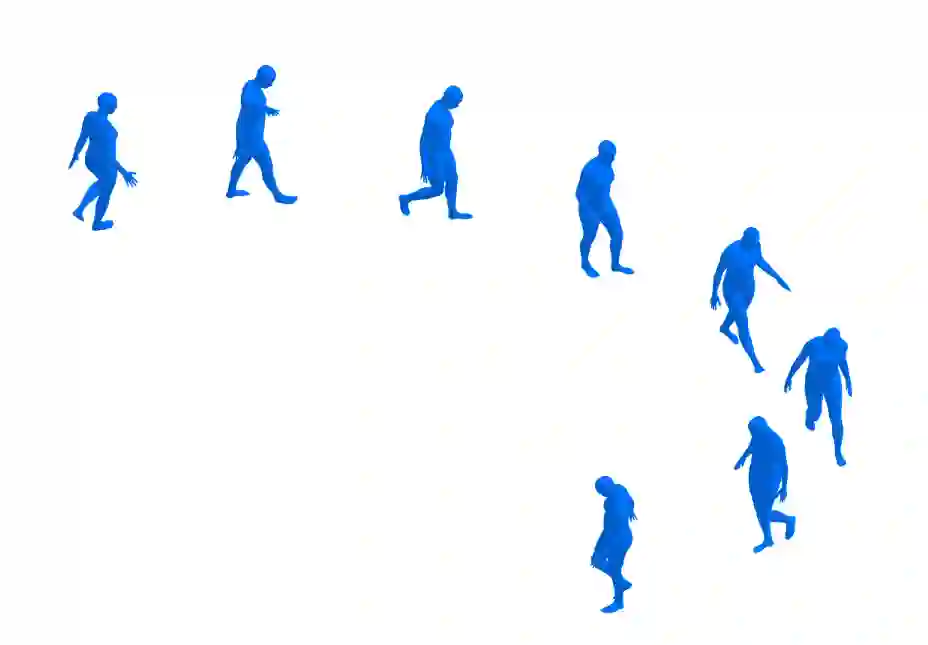

Achieving highly diverse and perceptually consistent 3D character animations with natural motion and low computational costs remains a challenge in computer animation. Existing methods often struggle to provide the nuanced complexity of human movement, resulting in perceptual inconsistencies and motion artifacts. To tackle these issues, we introduce FlowMotion, a novel approach that leverages Conditional Flow Matching (CFM) for improved motion synthesis. FlowMotion incorporates an innovative training objective that more accurately predicts target motion, reducing the inherent jitter associated with CFM while enhancing stability, realism, and computational efficiency in generating animations. This direct prediction approach enhances the perceptual quality of animations by reducing erratic motion and aligning the training more closely with the dynamic characteristics of human movement. Our experimental results demonstrate that FlowMotion achieves higher balance between motion smoothness and generalization capability while maintaining the computational efficiency inherent in flow matching compared to state-of-the-art methods.

翻译:在计算机动画领域,实现高度多样化、感知一致、运动自然且计算成本低的3D角色动画仍是一项挑战。现有方法通常难以捕捉人体运动的细微复杂性,导致感知不一致和运动伪影。为解决这些问题,我们提出了FlowMotion,一种利用条件流匹配(CFM)来改进运动合成的新方法。FlowMotion引入了一种创新的训练目标,能够更准确地预测目标运动,从而减少CFM固有的抖动,同时在生成动画时增强稳定性、真实感和计算效率。这种直接预测方法通过减少不规则运动,并使训练更贴近人体运动的动态特性,从而提升了动画的感知质量。实验结果表明,与现有先进方法相比,FlowMotion在运动平滑性与泛化能力之间取得了更好的平衡,同时保持了流匹配方法固有的计算效率。