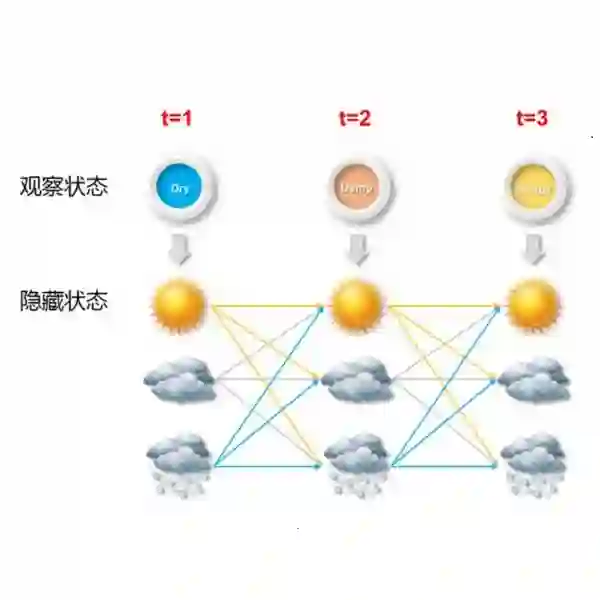

The Hidden Markov Model (HMM) is a widely-used statistical model for handling sequential data. However, the presence of missing observations in real-world datasets often complicates the application of the model. The EM algorithm and Gibbs samplers can be used to estimate the model, yet suffering from various problems including non-convexity, high computational complexity and slow mixing. In this paper, we propose a collapsed Gibbs sampler that efficiently samples from HMMs' posterior by integrating out both the missing observations and the corresponding latent states. The proposed sampler is fast due to its three advantages. First, it achieves an estimation accuracy that is comparable to existing methods. Second, it can produce a larger Effective Sample Size (ESS) per iteration, which can be justified theoretically and numerically. Third, when the number of missing entries is large, the sampler has a significant smaller computational complexity per iteration compared to other methods, thus is faster computationally. In summary, the proposed sampling algorithm is fast both computationally and theoretically and is particularly advantageous when there are a lot of missing entries. Finally, empirical evaluations based on numerical simulations and real data analysis demonstrate that the proposed algorithm consistently outperforms existing algorithms in terms of time complexity and sampling efficiency (measured in ESS).

翻译:隐马尔可夫模型(HMM)是一种广泛用于处理序列数据的统计模型。然而,现实世界数据集中缺失观测的存在常常使模型的应用复杂化。EM算法和吉布斯采样器可用于估计模型,但仍面临非凸性、高计算复杂度和混合速度慢等多种问题。本文提出一种折叠吉布斯采样器,通过积分掉缺失观测及其对应的隐状态,高效地从HMM的后验分布中采样。该采样器因其三大优势而具有快速性:首先,其估计精度与现有方法相当;其次,每次迭代能产生更大的有效样本量(ESS),这一点可从理论和数值上得到验证;第三,当缺失条目数量较大时,该采样器每次迭代的计算复杂度显著低于其他方法,因而计算速度更快。总之,所提出的采样算法在计算和理论层面均具有快速性,且在存在大量缺失条目时优势尤为明显。最后,基于数值模拟和实际数据分析的实证评估表明,该算法在时间复杂度和采样效率(以ESS衡量)方面均持续优于现有算法。