智能体化人工智能(Agentic AI)标志着从单步生成式模型向具备推理、规划、执行及长程任务自适应能力系统的重大转变。通过整合存储器、工具调用及迭代决策循环,此类系统能够在现实环境中实现持续且自主的工作流。 本综述旨在探讨智能体化 AI 对网络安全的影响。在防御端,智能体能力可实现大规模的持续监测、自主事件响应、自适应威胁狩猎以及欺诈检测。与之相对,上述特性也因加速了侦察、漏洞利用、协同作战及社会工程学攻击,从而增强了对抗端的威力。 这种双重用途(dual-use)动态暴露了现有治理、保障及问责机制的根本性缺陷,因为这些机制主要针对非自主且短生命周期的 AI 系统而设计。为应对这些挑战,本文调研了专门针对智能体系统设计的映射威胁模型、安全框架及评估管线,并分析了包括智能体串通、连锁故障、监管规避及记忆投毒在内的系统性风险。最后,本文展示了三个具有代表性的用例实现,旨在说明智能体化 AI 在实际网络安全工作流中的行为模式,以及设计决策如何影响系统的可靠性、安全性与运行效能。

https://www.zhuanzhiai.com/paper/9837f018e39bd2c79e3839818346b2661

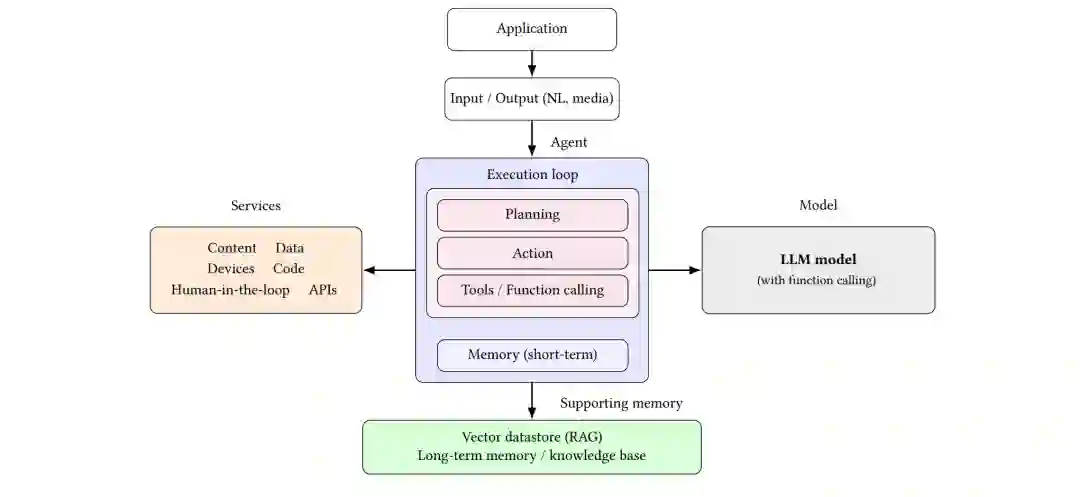

- 引言 (Introduction) 人工智能已从基于规则的自动化演进至生成式 AI(GenAI),并于近期发展为具备自主推理、规划和决策能力的智能体化模型(Agentic Models)。尽管大型语言模型(LLMs)等生成式 AI 系统在很大程度上仍属于被动响应和提示驱动型,但智能体化 AI 引入了持久化状态(Persistent State)、工具调用以及自导向控制循环,使其能够在长程、多步工作流中进行规划、行动与修正。这种从孤立推理向自主代理的转变,标志着 AI 系统参与数字生态系统方式的根本性变革。

网络安全是受此转型影响最直接的领域之一。安全运营本质上涉及持续监测、顺序决策、跨工具协作以及对对抗行为的自适应——这些特性与智能体化 AI 的能力高度契合。受运营压力和全球近四百万专业人才缺口的驱动,各组织正迅速采用 AI 辅助安全解决方案。市场预测也印证了这一势头:全球网络安全领域的 AI 支出预计将从 2024 年的 248 亿美元增长至 2034 年的 1465 亿美元 [85]。智能体化 AI 通过自动化告警分流、自主事件响应、可扩展的红蓝对抗模拟以及持续的安全运营中心(SOC)支持,极大地增强了人类的能力。

与此同时,自主性的提升也从根本上改变了威胁态势。那些能够实现防御协同的功能——如规划、记忆、工具编排和多智能体交互——同样可能被利用来增强攻击行动。智能体可以自主进行侦察、调整漏洞利用策略、协调社会工程学攻击并逃避监管。因此,智能体化 AI 在网络安全中引入了显著的双重用途困境(Dual-use Dilemma):它在强化防御的同时,也同步放大了对抗能力。

这种双重用途动态暴露了现有安全、保障和治理模型的局限性。当前大多数控制措施都假设 AI 系统是短生命周期的、有人参与(Human-in-the-loop)或范围有限的。相比之下,智能体化 AI 系统具备持续运行、保留长期记忆、与其他智能体协作以及在减少人类监督的情况下做出重大决策的特性。这些属性引入了系统性风险——包括突发性串通、连锁故障、记忆投毒和监管规避——而传统的以模型为中心的安全框架或基于生命周期的安全框架无法充分捕捉这些风险。

虽然先前的研究探讨了 AI 安全的孤立方面,或入侵检测强化学习等特定应用,但并未提供将智能体化 AI 作为网络安全参与者的整体视角。其自主性、持久性和多智能体交互在带来新机遇的同时,也伴随着突发串通、监管规避和治理缺口等系统性风险。本综述通过综合防御、攻击及治理导向的网络安全背景下的智能体化 AI,填补了这一空白。

本综述的主要贡献如下:

概念基础:回顾了智能体化 AI 的演进及其与生成式 AI 的关系,分析了核心设计属性、自主权等级及参考架构。 * 安全用例:概述了防御型及企业级应用,包括 SOC 自动化、持续监测、异常检测、内部威胁检测、漏洞管理及金融欺诈防御。 * 攻击性应用:调研了智能体化 AI 在红蓝对抗模拟、自主渗透测试和 CTF 自动化中的新兴攻击用途,并重点关注双重用途问题。 * 安全展望:深入分析了智能体化 AI 特有的系统性风险(包括串通、合成内部威胁和突发行为)及其对治理的影响。 * 量子考量:分析了量子计算与网络安全中智能体化 AI 的交集,包括量子智能体、量子机器学习和后量子密码学。 * 框架与治理:评述了支持智能体化 AI 安全部署与运行控制的安全及治理框架。 * 基准与评估:分析了针对智能体化 AI 安全性的基准测试、评估管线及测试平台,并指出了现有差距。 * 用例实现:提供了三个将智能体化 AI 集成到网络安全工作流中的原创实现,总结了实践经验。