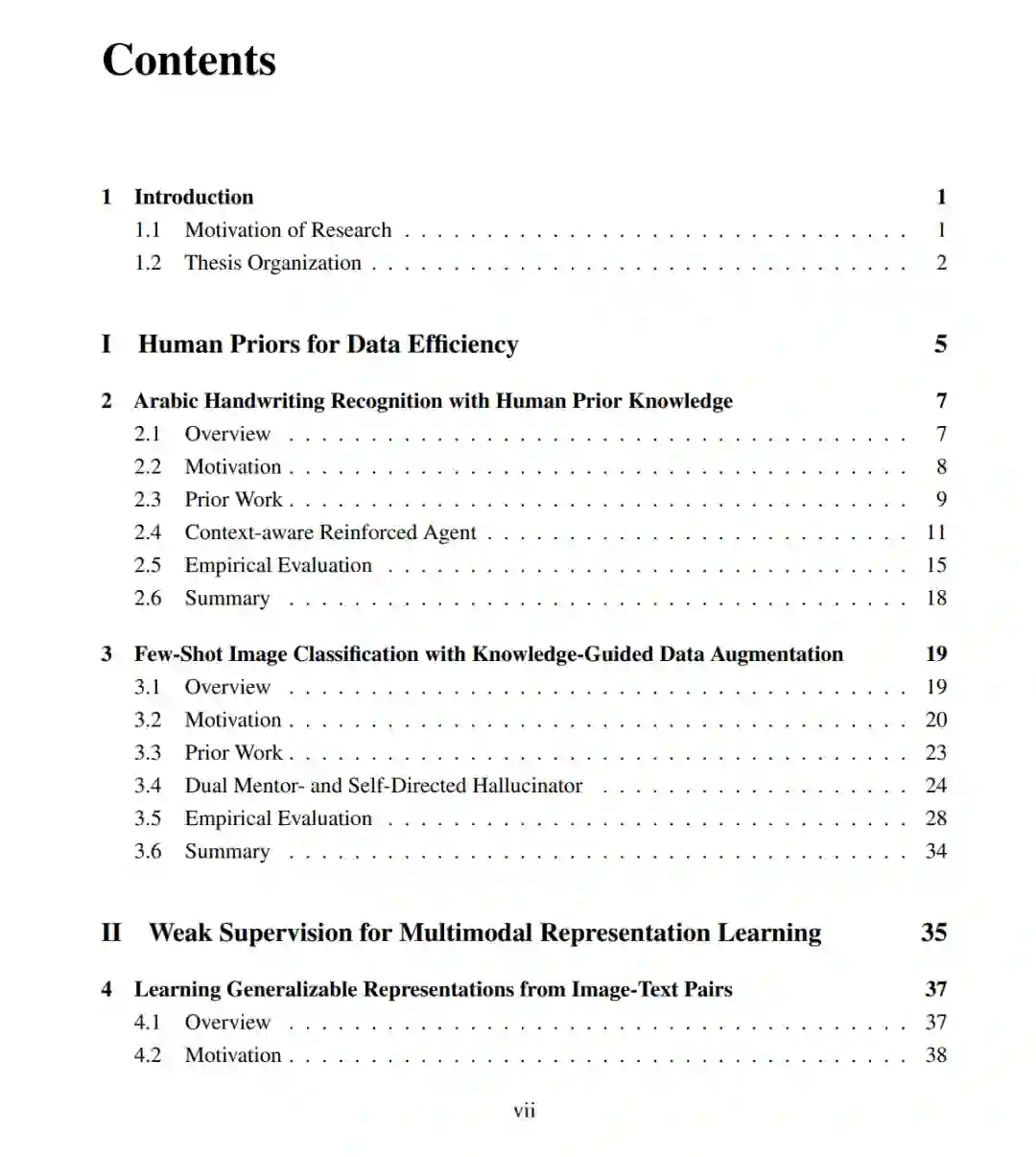

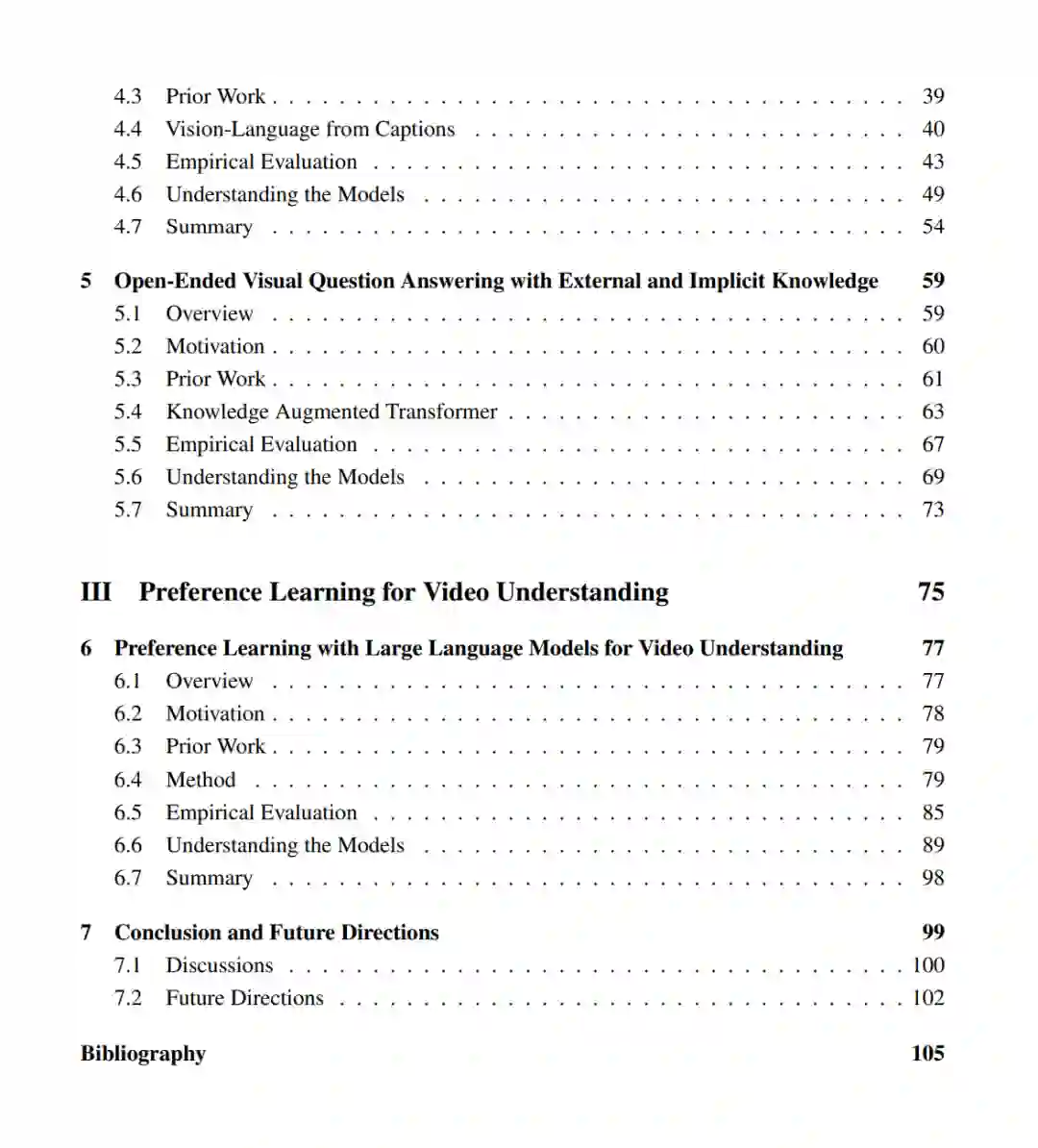

多模态学习(Multimodal learning)整合了视觉、语言和声音信息,在人类感知与认知中发挥着核心作用。人类能够自然地结合不同模态的输入来理解复杂环境,通过有限的示例进行学习,并跨任务进行迁移泛化。受此启发,多模态学习领域的近期研究在视觉问答(VQA)、图文检索和多模态信息提取等任务中取得了显著进展。尽管成就斐然,现有模型仍面临关键挑战,限制了其在真实世界场景中的可扩展性和适用性。 一个主要的局限是:无论是在预训练还是下游任务中,模型都高度依赖大规模的人工标注数据集。这类数据的收集工作劳动强度大、成本高昂且难以规模化,特别是对于涉及上下文和时序推理的复杂模态(如开放式推理和视频理解)而言。此外,这些模型在标注数据稀缺的低数据场景(low-resource settings)下往往难以实现泛化。同时,许多前沿模型采用“闭卷(closed-book)”模式训练,即所有知识均存储在模型参数中。这阻碍了模型动态整合外部知识源(如结构化数据库或大语言模型)的能力,限制了其在开放域推理中的灵活性与可解释性。 本论文通过三项核心策略推进数据高效的多模态学习,旨在解决上述局限。首先,我们研究了如何将结构化人类先验(structured human priors)嵌入到模型设计与训练中,以提升模型在小样本范式下的学习效率与泛化能力。其次,我们探索了弱监督信号(weak supervision signals)的利用——例如自然生成的图文对和外部知识库——以增强表示学习,从而减少对海量手工标注的依赖。第三,我们引入了偏好学习(preference-learning)框架,利用大语言模型(LLM)指导复杂任务的训练,特别是在传统标签难以定义或量化的视频理解和开放域推理领域。通过这些组成部分,本研究旨在减少对显式监督的需求,同时提升模型的性能、可解释性与自适应能力,为构建更具扩展性且鲁棒的多模态人工智能系统做出贡献。