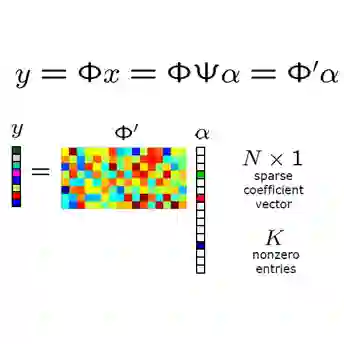

Compressed sensing has been a very successful high-dimensional signal acquisition and recovery technique that relies on linear operations. However, the actual measurements of signals have to be quantized before storing or processing. 1(One)-bit compressed sensing is a heavily quantized version of compressed sensing, where each linear measurement of a signal is reduced to just one bit: the sign of the measurement. Once enough of such measurements are collected, the recovery problem in 1-bit compressed sensing aims to find the original signal with as much accuracy as possible. The recovery problem is related to the traditional "halfspace-learning" problem in learning theory. For recovery of sparse vectors, a popular reconstruction method from 1-bit measurements is the binary iterative hard thresholding (BIHT) algorithm. The algorithm is a simple projected sub-gradient descent method, and is known to converge well empirically, despite the nonconvexity of the problem. The convergence property of BIHT was not theoretically justified, except with an exorbitantly large number of measurements (i.e., a number of measurement greater than $\max\{k^{10}, 24^{48}, k^{3.5}/ε\}$, where $k$ is the sparsity, $ε$ denotes the approximation error, and even this expression hides other factors). In this paper we show that the BIHT algorithm converges with only $\tilde{O}(\frac{k}ε)$ measurements. Note that, this dependence on $k$ and $ε$ is optimal for any recovery method in 1-bit compressed sensing. With this result, to the best of our knowledge, BIHT is the only practical and efficient (polynomial time) algorithm that requires the optimal number of measurements in all parameters (both $k$ and $ε$). This is also an example of a gradient descent algorithm converging to the correct solution for a nonconvex problem, under suitable structural conditions.

翻译:压缩感知是一种非常成功的高维信号采集与恢复技术,其依赖于线性运算。然而,信号的实际测量值在存储或处理前必须进行量化。1比特压缩感知是压缩感知的一种高度量化版本,其中信号的每个线性测量被缩减为仅一个比特:即测量值的符号。一旦收集到足够多的此类测量值,1比特压缩感知中的恢复问题旨在尽可能准确地找到原始信号。该恢复问题与学习理论中传统的"半空间学习"问题相关。对于稀疏向量的恢复,一种从1比特测量值中重建的流行方法是二元迭代硬阈值(BIHT)算法。该算法是一种简单的投影次梯度下降方法,尽管问题本身是非凸的,但已知其在经验上收敛良好。BIHT的收敛性此前在理论上并未得到证明,除非使用极其大量的测量值(即测量数量大于$\max\{k^{10}, 24^{48}, k^{3.5}/ε\}$,其中$k$表示稀疏度,$ε$表示近似误差,甚至该表达式还隐藏了其他因素)。本文中,我们证明BIHT算法仅需$\tilde{O}(\frac{k}ε)$个测量值即可收敛。值得注意的是,这种对$k$和$ε$的依赖关系对于1比特压缩感知中的任何恢复方法都是最优的。基于这一结果,据我们所知,BIHT是唯一在所有参数(包括$k$和$ε$)上均需要最优测量数量的实用且高效(多项式时间)算法。这也是梯度下降算法在适当结构条件下收敛于非凸问题正确解的一个范例。